Pro ty, kteří nemají zkušenosti s kódováním, může být proces vytváření webového škrabadla náročný. Nicméně, existuje naštěstí software pro web scraping, který je dostupný jak pro programátory, tak i pro ty, kteří s kódováním nepracují. Tento software je speciálně navržený pro extrahování relevantních dat z webových stránek. Tyto nástroje jsou užitečné pro každého, kdo potřebuje získávat data z internetu. Získané informace se ukládají do místního souboru v počítači nebo do databáze. Jedná se o techniku automatizovaného sběru dat z webových stránek. Předkládáme vám seznam 31 nejlepších bezplatných nástrojů pro web scraping.

31 Skvělých Nástrojů pro Web Scraping

Níže naleznete výběr nejlepších nástrojů pro web scraping. Tento seznam obsahuje jak komerční nástroje, tak i open-source řešení, včetně odkazů na jejich webové stránky.

1. Outwit

Outwit je rozšíření pro Firefox, které je snadno instalovatelné přímo z obchodu s doplňky Firefoxu.

- Tento nástroj pro získávání dat usnadňuje shromažďování kontaktů z webu a e-mailů.

- Nabízí tři varianty zakoupení, které se liší v závislosti na vašich potřebách:

- Pro

- Expert

- Enterprise edice

- Získávání přesných dat pomocí Outwit centra nevyžaduje žádné znalosti programování.

- Pomocí jediného kliknutí na tlačítko prozkoumání můžete prohledávat stovky webových stránek.

2. ParseHub

ParseHub je dalším z vynikajících bezplatných nástrojů pro web scraping.

- Umožňuje čištění textu a HTML před samotným stažením dat.

- Jeho sofistikovaný webový škrabák usnadňuje výběr dat, která chcete extrahovat.

- Umožňuje ukládat extrahovaná data v libovolném formátu pro další analýzu, což ho činí jedním z nejlepších nástrojů pro data scraping.

- Nabízí uživatelsky přívětivé grafické rozhraní.

- Tento nástroj pro web scraping umožňuje automaticky stahovat a ukládat data na servery.

3. Apify

Apify je další skvělý nástroj pro web scraping a automatizaci, který vám umožňuje vytvořit API pro libovolný web. Obsahuje vestavěné proxy pro rezidenční a datová centra, které usnadňují extrakci dat.

- Apify se stará o infrastrukturu a fakturaci, což vývojářům umožňuje vydělávat pasivní příjem tvorbou nástrojů pro ostatní.

- Dostupné konektory zahrnují Zapier, Integromat, Keboola a Airbyte.

- Apify Store nabízí hotová řešení pro scraping oblíbených webů, jako jsou Instagram, Facebook, Twitter a Mapy Google.

- Strukturovaná data lze stahovat ve formátech JSON, XML, CSV, HTML a Excel.

- Apify Proxy nabízí funkce jako HTTPS, geolokační cílení, inteligentní rotaci IP adres a proxy servery pro Google SERP.

- K dispozici je 30denní zkušební verze proxy s kreditem 5 USD na platformě.

4. Scrapestack

Scrapestack využívá více než 2000 firem a spoléhá na toto unikátní API, které je poháněno apilayerem. Patří k špičce mezi bezplatnými nástroji pro web scraping.

- Využívá globální fond IP adres o velikosti 35 milionů datových center.

- Umožňuje provádět mnoho API požadavků současně.

- Podporuje dešifrování CAPTCHA a vykreslování JavaScriptu.

- Nabízí bezplatné i placené možnosti.

- Scrapestack je online REST API pro scraping, které pracuje v reálném čase.

- Scrapestack API umožňuje scraping webových stránek v milisekundách pomocí milionů proxy IP adres, prohlížečů a řešení CAPTCHA.

- Požadavky na web scraping lze posílat z více než 100 různých míst po celém světě.

5. FMiner

FMiner je populární online program pro web scraping, extrakci dat, screen scraping, a podporu pro makra a webové prohlížeče. Je dostupný pro Windows a Mac OS.

- Umožňuje sběr dat z dynamických webových stránek Web 2.0, které se obtížně procházejí.

- Nabízí vizuální editor, který usnadňuje vytváření projektů pro extrakci dat.

- Využívá kombinaci struktur odkazů, rozbalovacích nabídek a porovnávání vzorů URL pro navigaci po webových stránkách.

- Pro ochranu webu pomocí CAPTCHA lze použít automatické služby decaptcha třetích stran nebo ruční zadání.

6. Sequentum

Sequentum je výkonný nástroj pro velká data, který slouží k získávání spolehlivých online dat. Jedná se o další z nejlepších bezplatných nástrojů pro web scraping.

- Zajišťuje rychlejší získávání online dat ve srovnání s alternativními řešeními.

- Umožňuje přecházet mezi více platformami.

- Je to efektivní webový škrabák pro růst vaší společnosti. Nabízí snadno ovladatelné funkce včetně vizuálního editoru typu point-and-click.

- Vyhrazené webové API usnadňuje vývoj webových aplikací a umožňuje spouštění webových dat přímo z vašeho webu.

7. Agenty

Agenty je program pro web scraping, extrakci textu a OCR, který využívá automatizaci robotických procesů.

- Tento program umožňuje opětovné použití zpracovaných dat pro účely analýzy.

- Agenta můžete vytvořit pouhými několika kliknutími myši.

- Po dokončení úkolu obdržíte e-mailové upozornění.

- Umožňuje připojení k Dropboxu a využití zabezpečeného FTP.

- K dispozici jsou protokoly aktivit pro všechny instance.

- Může vám pomoci zvýšit úspěšnost vašeho podnikání.

- Usnadňuje implementaci obchodních pravidel a vlastních logik.

8. Import.io

Import.io vám pomáhá vytvářet vlastní datové sady importem dat z webových stránek a jejich exportem do CSV. Jedná se o další z nejlepších nástrojů pro web scraping. Níže jsou uvedeny jeho vlastnosti.

- Snadná obsluha webových formulářů a přihlašování.

- Je to jedno z nejlepších řešení pro odstraňování dat, které využívá API a webhooky k integraci dat do aplikací.

- Poskytuje přehledy formou reportů, grafů a vizualizací.

- Extrakce dat by měla být plánována dopředu.

- Cloud Import.io umožňuje ukládat a přistupovat k datům.

- Lze automatizovat interakci s webem a pracovními postupy.

9. Webz.io

Webz.io vám umožňuje procházet stovky webových stránek a získávat okamžitý přístup ke strukturovaným datům v reálném čase. Jedná se o jeden z nejlepších bezplatných nástrojů pro web scraping.

Získáte organizované, strojově čitelné datové sady ve formátech JSON a XML.

- Poskytuje přístup k historickým zdrojům dat, které pokrývají více než deset let.

- Umožňuje přístup k velké databázi zdrojů bez dalších nákladů.

- K provedení podrobné analýzy a prozkoumání datových sad zdrojů můžete použít pokročilé filtry.

10. Scrape Owl

Scrape Owl je platforma pro web scraping, která je snadno použitelná a ekonomicky výhodná.

- Hlavním cílem Scrape Owl je extrahovat jakýkoli typ dat, včetně e-commerce, pracovních tabulek a seznamů nemovitostí.

- Před extrahováním materiálu můžete spustit vlastní JavaScript.

- Můžete použít geolokaci k obejití místních omezení a získání přístupu k místnímu obsahu.

- Poskytuje spolehlivou funkci čekání.

- Je podporováno vykreslování JavaScriptu celé stránky.

- Tuto aplikaci lze použít přímo v Tabulkách Google.

- Nabízí bezplatnou zkušební verzi 1000 kreditů, abyste si mohli službu vyzkoušet před zakoupením jakéhokoli členství. Není nutné používat kreditní kartu.

11. Scrapingbee

Scrapingbee je webové API pro scraping, které se stará o nastavení proxy a bezhlavých prohlížečů.

- Může spouštět Javascript na stránkách a střídat proxy pro každý požadavek, takže můžete číst nezpracované HTML bez toho, aby vás web zařadil na černou listinu.

- K dispozici je také druhé rozhraní API pro extrahování výsledků vyhledávání Google.

- Podporuje vykreslování JavaScriptu.

- Má automatickou funkci rotace proxy.

- Tuto aplikaci lze používat přímo v Tabulkách Google.

- Pro používání programu je nutný webový prohlížeč Chrome.

- Je ideální pro scraping Amazonu.

- Umožňuje extrahovat výsledky Google.

12. Bright Data

Bright Data je přední světová online datová platforma, která nabízí cenově dostupná řešení pro hromadný sběr veřejných webových dat. Umožňuje snadnou konverzi nestrukturovaných dat na strukturovaná data. Poskytuje kvalitní zákaznickou podporu, přičemž je plně transparentní a v souladu s předpisy.

- Je vysoce přizpůsobitelný, nabízí předem připravená řešení a je rozšiřitelný a konfigurovatelný.

- Bright Data poskytuje automatizovaný a personalizovaný tok dat na jednom řídicím panelu, bez ohledu na velikost sběru dat.

- Poskytuje nepřetržitou zákaznickou podporu.

- Datové soubory jsou přizpůsobeny potřebám vaší firmy, od trendů e-commerce a dat ze sociálních sítí po konkurenční zpravodajství a průzkum trhu.

- Automatizací přístupu ke spolehlivým datům ve vašem oboru se můžete soustředit na svůj hlavní podnik.

- Je velmi efektivní, protože používá bezkódové řešení a využívá méně zdrojů.

- Je nejspolehlivější, protože poskytuje nejkvalitnější data, vyšší provozuschopnost, rychlejší data a lepší zákaznické služby.

13. Scraper API

Scraper API je nástroj, který se stará o proxy servery, prohlížeče a řešení CAPTCHA.

- Nabízí bezkonkurenční rychlost a spolehlivost, což umožňuje vytvářet škálovatelné webové škrabky.

- Můžete získat HTML z libovolné webové stránky pomocí jediného volání API.

- Nastavení je jednoduché, stačí odeslat požadavek GET s klíčem API a URL na API koncový bod.

- Usnadňuje vykreslování JavaScriptu.

- Umožňuje přizpůsobit typ požadavku a hlavičky pro každý požadavek.

- Rotující proxy s geografickou polohou.

14. Dexi Intelligent

Dexi intelligent je online scrapingová aplikace, která vám umožňuje proměnit jakékoli množství webových dat na rychlou komerční hodnotu.

- Tento online nástroj pro scraping vám umožní ušetřit peníze a čas.

- Zvyšuje produktivitu, přesnost a kvalitu.

- Umožňuje nejrychlejší a nejefektivnější extrakci dat.

- Nabízí rozsáhlý systém pro zachycování znalostí.

15. Diffbot

Diffbot vám umožňuje rychle získat řadu důležitých faktů z internetu.

- Pomocí AI extraktorů můžete extrahovat přesná strukturovaná data z libovolné URL.

- Neplatíte za časově náročné prohledávání webových stránek nebo manuální dotazování.

- Pro vytvoření úplného a přesného obrazu každého objektu se slučuje mnoho zdrojů dat.

- Pomocí AI Extractors můžete extrahovat strukturovaná data z libovolné URL.

- S Crawlbotem můžete rozšířit extrakci na desítky tisíc domén.

- Funkce Knowledge Graph poskytuje webu přesná, úplná a hluboká data, která BI potřebuje k poskytování smysluplných přehledů.

16. Data Streamer

Data Streamer je technologie, která vám umožňuje získávat materiál ze sociálních sítí z celého internetu.

- Jedná se o jeden z největších online škrabáků, který využívá zpracování přirozeného jazyka k načtení klíčových metadat.

- Kibana a Elasticsearch se používají k poskytování integrovaného fulltextového vyhledávání.

- Založeno na algoritmech získávání informací, integrovaném odstraňování standardního obsahu a extrakci obsahu.

- Postaveno na infrastruktuře odolné proti chybám, která poskytuje vysokou dostupnost informací.

17. Mozenda

Pomocí Mozendy můžete extrahovat text, obrázky a PDF soubory z webových stránek.

- Ke shromažďování a publikování online dat můžete použít svůj vybraný nástroj BI nebo databázi.

- Je to jeden z nejlepších online nástrojů pro scraping, který organizuje a formátuje datové soubory pro publikování.

- S rozhraním point-and-click můžete vytvořit webové škrabací agenty během několika minut.

- K shromažďování webových dat v reálném čase použijte funkce Job Sequencer a Request Blocking.

- Správa účtů a zákaznická podpora patří k nejlepším v oboru.

18. Rozšíření Data Miner pro Chrome

Web scraping a sběr dat je snadnější s pluginem prohlížeče Data Miner.

- Má schopnost procházet více stránek a nabízí dynamickou extrakci dat.

- Výběr dat lze provádět různými způsoby.

- Umožňuje zkoumat extrahované informace.

- Extrahovaná data lze uložit jako soubor CSV.

- K ukládání extrahovaných dat se používá lokální úložiště.

- Doplněk Web Scraper pro Chrome stahuje data z dynamických webů.

- Soubory Sitemap lze importovat a exportovat.

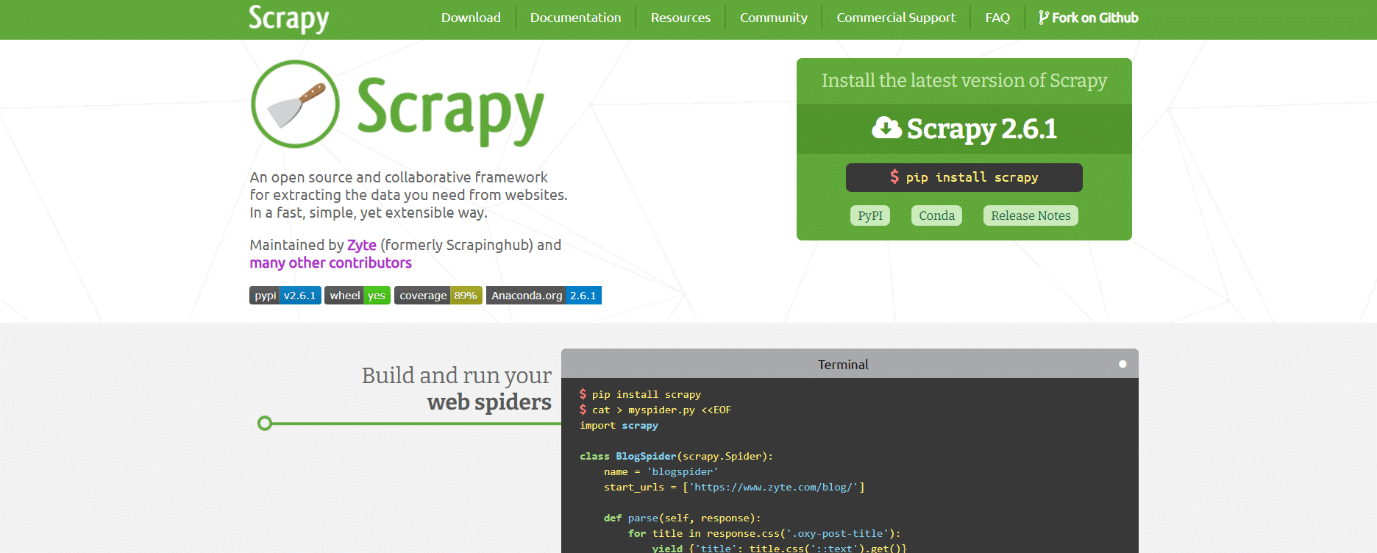

19. Scrapy

Scrapy je dalším z vynikajících nástrojů pro web scraping. Jedná se o open-source framework pro online scraping založený na Pythonu, který slouží k vytváření webových škrabáků.

- Poskytuje veškeré nástroje, které potřebujete k rychlému extrahování dat z webových stránek, jejich analýze a uložení do struktury a formátu, který si vyberete.

- Tento nástroj pro data scraping je nezbytný, pokud máte rozsáhlý projekt web scrapingu a chcete maximalizovat jeho efektivitu při zachování vysoké flexibility.

- Data lze exportovat jako JSON, CSV nebo XML.

- Podporovány jsou Linux, Mac OS X a Windows.

- Je vyvinut nad technologií asynchronních sítí Twisted, což je jedna z jeho klíčových vlastností.

- Scrapy je pozoruhodný svou jednoduchostí použití, rozsáhlou dokumentací a aktivní komunitou.

20. ScrapeHero Cloud

ScrapeHero využil své dlouholeté zkušenosti s procházením webu a transformoval je do ekonomických a snadno použitelných předem sestavených prohledávačů a API pro data scraping ze stránek jako Amazon, Google, Walmart a další.

- Cloudové prohledávače ScrapeHero zahrnují automaticky rotující proxy a možnost spouštět mnoho prohledávačů současně.

- Abyste mohli používat ScrapeHero Cloud, nemusíte stahovat ani se učit používat žádné nástroje nebo software pro data scraping.

- Prohledávače ScrapeHero Cloud vám umožňují okamžitě extrahovat data a exportovat je ve formátech JSON, CSV nebo Excel.

- Klienti s bezplatným a jednoduchým tarifem ScrapeHero Cloud dostávají e-mailovou pomoc, zatímco všechny ostatní tarify dostávají prioritní službu.

- Prohledávače ScrapeHero Cloud lze také konfigurovat tak, aby splňovaly specifické požadavky zákazníků.

- Jedná se o webový škrabák založený na prohlížeči, který funguje s jakýmkoli webovým prohlížečem.

- Nepotřebujete žádné znalosti programování ani vývoj škrabáku; je to stejně snadné jako klikání, kopírování a vkládání!

21. Data Scraper

Data Scraper je bezplatná online aplikace pro web scraping, která stahuje data z jedné webové stránky a ukládá je jako soubory CSV nebo XSL.

- Jedná se o rozšíření prohlížeče, které převádí data do tabulkového formátu.

- Instalace pluginu vyžaduje použití prohlížeče Google Chrome.

- S bezplatnou verzí můžete seškrábat 500 stránek měsíčně; pokud chcete seškrábat více stránek, musíte upgradovat na jeden z placených tarifů.

22. Visual Web Ripper

Visual Web Ripper je nástroj pro automatické web scraping.

- Pomocí tohoto nástroje můžete získávat datové struktury z webových stránek nebo výsledků vyhledávání.

- Data lze exportovat do souborů CSV, XML a Excel a nabízí uživatelsky přívětivé rozhraní.

- Může také extrahovat data z dynamických webových stránek, jako jsou ty, které používají AJAX.

- Stačí nastavit několik šablon a webový škrabák se postará o zbytek.

- Visual Web Ripper nabízí možnosti plánování a pošle vám e-mail, pokud projekt selže.

23. Octoparse

Octoparse je uživatelsky přívětivá aplikace pro web scraping s vizuálním rozhraním. Je to jeden z nejlepších bezplatných nástrojů pro web scraping. Níže jsou uvedeny jeho vlastnosti.

- Jeho rozhraní typu point-and-click usnadňuje výběr informací, které chcete z webové stránky získat. Octoparse si poradí se statickými i dynamickými webovými stránkami díky technologiím AJAX, JavaScript, cookies a dalším možnostem.

- Nyní jsou k dispozici pokročilé cloudové služby, které umožňují extrahovat velké množství dat.

- Stažené informace lze uložit jako soubory TXT, CSV, HTML nebo XLSX.

- Bezplatná verze Octoparse vám umožňuje vytvořit až 10 škrabáků; placené tarify však nabízejí funkce, jako je API a velký počet anonymních IP proxy, které urychlí vaši extrakci a umožní vám stahovat velké objemy dat v reálném čase.

24. WebHarvy

Vizuální webový škrabák WebHarvy má vestavěný prohlížeč pro extrahování dat z webových stránek. Je to také jeden z nejlepších nástrojů pro web scraping. Zde je několik funkcí tohoto nástroje.

- Nabízí rozhraní typu point-and-click, které usnadňuje výběr položek.

- Tato škrabka má tu výhodu, že nevyžaduje psaní kódu.

- K ukládání dat lze použít soubory CSV, JSON a XML.

- Je také možné uložit data do databáze SQL. WebHarvy má funkci stírání kategorií na více úrovních, která dokáže extrahovat data ze stránek se seznamy sledováním jednotlivých úrovní připojení kategorií.

- Regulární výrazy mohou být použity s nástrojem pro web scraping, což vám dává další flexibilitu.

- Můžete nastavit proxy servery, které udrží vaši IP adresu skrytou při stahování dat z webových stránek, což vám umožní zachovat určitou míru soukromí.

25. PySpider

PySpider je také jeden z nejlepších bezplatných nástrojů pro web scraping, který je webovým prohledávačem založeným na Pythonu. Níže je uvedeno několik funkcí tohoto nástroje.

- Vyznačuje se distribuovanou architekturou a podporuje stránky Javascript.

- Můžete mít více spuštěných škrabáků současně. PySpider dokáže ukládat data na libovolném backendu, který si vyberete, včetně MongoDB, MySQL, Redis a dalších.

- K dispozici jsou fronty zpráv, jako RabbitMQ, Beanstalk a Redis.

- Jednou z výhod PySpideru je jeho jednoduché uživatelské rozhraní, které vám umožňuje měnit skripty, sledovat probíhající aktivity a zkoumat výsledky.

- Informace lze stahovat ve formátech JSON a CSV.

- PySpider je dobrá volba, pokud pracujete s uživatelským rozhraním založeným na webu.

- Funguje také s weby, které hod