Přehled nejčastějších podvodů využívajících technologii deepfake.

Začněme s ukázkou, jak může vypadat podvod s hlasem, který je prezentován jako projev „POTUS“ Joe Bidena:

Tato ukázka ilustruje, jak snadno lze vytvořit (hlasový) deepfake. Využil jsem bezplatný nástroj pro klonování hlasu s pomocí umělé inteligence. Strávil jsem pouhých pět minut psaním textu (s pomocí ChatGPT) a jeho konverzí do (Bidenova) hlasu.

Podvody s deepfake jsou však mnohem sofistikovanější. K jejich vytvoření stačí několik kvalitních fotografií, videí nebo zvukových záznamů oběti a výkonná grafická karta.

Nicméně, cílem tohoto článku není diskutovat o procesu tvorby deepfake videí, ani o jejich odhalování.

Místo toho se v tomto textu seznámíme s krátkým úvodem do problematiky deepfakes a zmíníme několik typů podvodů, na které byste si měli dávat pozor.

Co jsou Deepfakes?

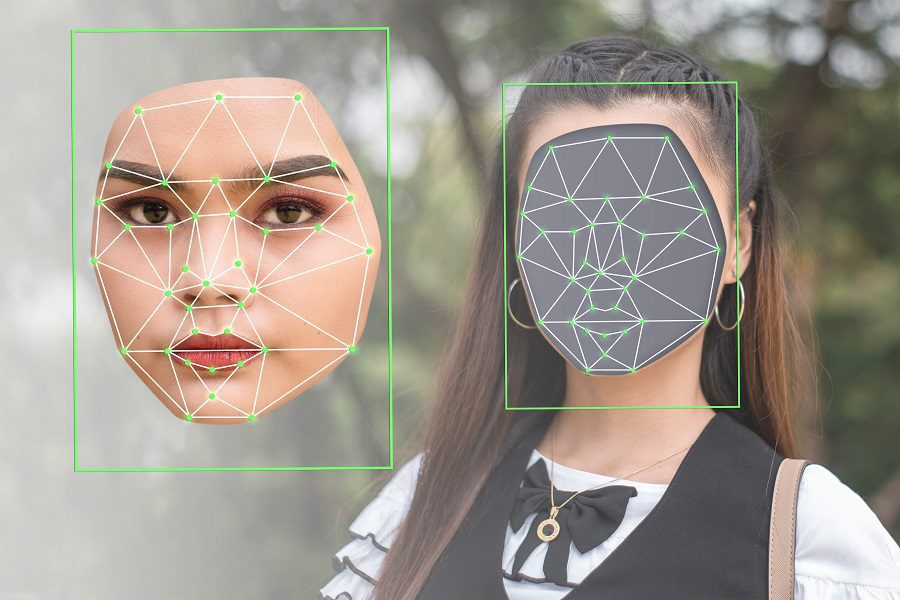

Termín deepfake vznikl spojením dvou slov: „deep“ (odvozeno od hlubokého učení, které se používá k jejich tvorbě) a „fake“ (označující falzifikát).

Jednoduše řečeno, algoritmy hlubokého učení se používají k vytváření realistických obrázků, zvukových záznamů nebo videoobsahu z původních dat s vysokým rozlišením.

Tento příklad je klasickou ukázkou deepfake a zdá se být poměrně přesvědčivý. Je však důležité si uvědomit, že technologie se neustále vyvíjí a zdokonaluje.

A ne vždy se jedná o zábavu nebo demonstraci schopností umělé inteligence. Závažným příkladem je situace, kdy byl „prezident Volodymyr Zelenskyj“ nucen se vzdát v rusko-ukrajinské válce.

Bohužel, takových případů je více. Podle zprávy Regula Forensics 2023 se 37 % globálních organizací setkalo s hlasovými podvody deepfake, 29 % zažilo podvody se syntetickým videem a 46 % bylo terčem pokusů o krádež identity.

Není to tedy jen o zábavě. Deepfake se často používá k šíření dezinformací a je zneužíván mnoha dalšími způsoby, které mohou být pro oběti nebezpečné a znepokojivé.

Boj proti deepfake obsahu není jednoduchý. Jedná se o vedlejší účinek významného pokroku v technologii umělé inteligence a fakt, že tyto nástroje jsou nyní široce dostupné pro veřejnost.

Proto je největší a nejčastější obranou, kterou máme, informovanost.

Zaměřme se tedy na toto a podívejme se na typy deepfake podvodů.

Typy Deepfake podvodů

Na základě obsahu a cíle lze deepfake podvody rozdělit do několika kategorií, například:

- Video impersonace (vydávání se za někoho jiného)

- Falešné rozhovory

- Falešné zprávy

- Hlasové podvody

- Honeytraps

- Zákaznická podpora

- Posudky

Podrobněji se na tyto podvody a některé jejich modifikace podíváme v následujících sekcích.

Video impersonace

Jedná se o známý typ deepfake podvodu, kdy vidíme vymyšlené video, které se obecně podobá známé osobě. Typickou obětí může být prezident země (jako například Obama deepfake), populární hollywoodská hvězda nebo generální ředitel významné společnosti.

Snadným cílem jsou tito lidé proto, že jsou jejich fotografie a projevy veřejně dostupné. Nástroje pro vytváření deepfake videí fungují velmi dobře s různými vstupy, dokáží zobrazit různé emoce, úhly obličeje, světelné podmínky, pozadí a další.

Účelem takové impersonace může být zábava, vydírání, politická motivace, pomluva, nebo cokoli jiného.

V některých případech se objevují deepfake videa členů rodiny, kteří žádají o peníze nebo přístup k cenným věcem.

Falešné rozhovory

Falešné rozhovory, které využívají technologii deepfake, se často zaměřují na vzdálené pracovní pozice z domova. Tyto podvody využívají deepfake videa v reálném čase prostřednictvím konferenčních programů, jako je Zoom.

Kromě získání nekvalitního kandidáta riskuje cílová společnost vystavení svého majetku podvodné osobě. Na základě jednání společnosti to může poškodit nejen její zdroje, ale i ohrozit zájmy země.

Snadnějším cílem deepfake rozhovorů může být získání platby v cizí měně.

Na druhou stranu mohou podvodníci účtovat nevinným kandidátům poplatek za pohovor, aby je dostali před „průmyslové magnáty“, a zajistili jim tak získání vysněné práce.

Falešné zprávy

Nejrozšířenějším deepfake podvodem jsou falešné zprávy. Takové online dezinformační kampaně představují rizika, která mohou mít fatální následky v ošemetných situacích, jako jsou nepokoje nebo války.

Může také poškodit pověst veřejných osobností, když jejich deepfake kopie provádí komentáře, které ve skutečnosti nikdy nepronesly.

Šíření propagandy usnadňují sociální média a streamovací platformy, jako je YouTube, které pomáhají šířit takové falešné zprávy rychlostí blesku. Vytváří se tak atmosféra, kdy jsou běžní uživatelé zmateni autenticitou všeho, co vidí.

Hlasové podvody

Syntetický hlas je dalším přírůstkem do seznamu triků poháněných umělou inteligencí, podobně jako deepfake videa a obrázky.

V jednom takovém případě Jennifer DeStefano z Arizony slyšela svou 15letou dceru vzlykat po telefonu, zatímco mužský hlas požadoval 1 milion dolarů za její propuštění. Matka byla přesvědčena, že její dcera je v nebezpečí. Než stačila zaplatit, zavolala kamarádka manželovi a potvrdila, že její dcera je v bezpečí.

Paní DeStefano později vyprávěla o tom, jak naprosto uvěřila hlasu, a to nejen kvůli zvuku, ale i tónu, který přesně odpovídal tomu, jak její dcera obvykle mluví.

Jedná se o klonování hlasu, které se provádí pomocí zvukových vzorků ze zdroje.

Honeytraps

Podle tradiční definice je honeytrap situace, kdy je subjekt navázán do vztahu za účelem vydírání citlivých informací. Honeytraps se obvykle zaměřují na vysoce postavené subjekty, jako jsou vojáci, vysocí vládní úředníci, nebo politici.

Díky technologii deepfake jsou tyto honeytraps většinou online a může je provádět kdokoli ve velkém. Oběť tak může dostávat žádosti o vztah od atraktivních partnerů prostřednictvím sociálních médií, které se rychle snaží sblížit, aby nakonec dosáhly finančního nebo informačního vydírání.

Takové deepfake podvody jsou obecně dobře naplánované operace, které probíhají v pravý čas, než nastraží konečnou past.

Zákaznická podpora

Podvody s technickou podporou jsou velmi běžné. Možná jste slyšeli o podvodech, kdy vás nějaký „zaměstnanec Microsoftu“ žádá o zaplacení za vyřešení „závažných“ problémů s počítačem.

Před nástupem deepfake, jejich přízvuk nebo neobvyklý způsob řeči prozrazoval zlomyslné úmysly. Nyní však mají tito podvodníci k dispozici umělou inteligenci, která dokáže snadno oklamat nevinné uživatele, aby si mysleli, že skutečně hovoří s legitimním zástupcem společnosti.

Posudky

Mnoho z nás si před nákupem jakéhokoli produktu přečte zákaznické recenze. Stejně tak i kontrola videoreferencí je běžným zvykem.

Tento typ deepfake podvodu vede k tomu, že více lidí ručí za špatné produkty, ovlivňuje nákupní rozhodnutí a vede k plýtvání penězi i časem zákazníků.

Je jich mnohem více!

Co kromě textu vídáte na internetu?

Řekl bych, že jsou to videa, obrázky a zvuk. Všechno toto lze s pomocí umělé inteligence manipulovat, což v blízké budoucnosti vytvoří z internetu živnou půdu pro podvody. Vzhledem k tomu, že vytváření deepfake je stále snadnější, je pro průměrného uživatele internetu obtížné zůstat „správně“ informován.

V takové situaci, kdy se jen stěží dá zastavit rozsáhlé zneužívání technologií, bychom se měli alespoň snažit zůstat v obraze.

P.S.: Pokud jde o zábavné aplikace, máte k dispozici deepfake aplikace pro tvorbu memů, které zaplaví sociální média.