Jak často se obracíte na chatboty či roboty poháněné umělou inteligencí (AI) při plnění úkolů nebo hledání odpovědí na své otázky?

Pokud vaše odpověď zní „často!“ nebo „stále!“, měli byste zbystřit 😟.

Ať už jste student, který s oblibou využívá AI roboty pro rešerše, nebo programátor, který spoléhá na AI při generování kódu, pravděpodobnost nepřesností ve výstupech AI je poměrně vysoká. Hlavním důvodem jsou nekonzistentnosti či zavádějící informace v trénovacích datech AI.

Ačkoli modely umělé inteligence a strojového učení (ML) mění svět – automatizují rutinní úkoly a řeší mnoho problémů, stále mají rezervy v generování přesných výsledků na základě zadaných požadavků.

Pokud trávíte hodně času s generátory obsahu a chatboty, brzy si všimnete, že dostáváte nepravdivé, irelevantní nebo dokonce vymyšlené odpovědi. Tyto jevy se označují jako halucinace nebo konfabulace AI a představují velký problém pro organizace i jednotlivce, kteří se spoléhají na generativní roboty s umělou inteligencí.

Ať už jste se s halucinacemi AI setkali nebo ne a chcete se o tomto tématu dozvědět více, tento článek se jím podrobně zabývá. Podíváme se, co halucinace AI znamená, proč k ní dochází, jaké jsou její příklady a zda je možné ji eliminovat.

Pojďme na to!

Co je to halucinace AI?

Halucinace AI nastává, když model umělé inteligence nebo velký jazykový model (LLM) vytváří nepravdivé, nepřesné nebo nelogické informace. Model AI generuje sebevědomou odpověď, která neodpovídá trénovacím datům nebo je s nimi v rozporu, a prezentuje data jako fakta, i když nedávají logický smysl!

Říká se, že chybovat je lidské!😅

Nástroje a modely umělé inteligence, jako je ChatGPT, jsou obvykle trénovány k predikci slov, která nejlépe odpovídají zadanému dotazu. I když roboti často generují věcné a přesné odpovědi, tento algoritmus někdy vede k tomu, že chybí uvažování. Kvůli tomu pak chatboti produkují faktické nesrovnalosti a nepravdivá tvrzení.

Jinými slovy, modely AI někdy „halucinují“ odpověď ve snaze vyhovět uživateli – ať už to znamená, že jsou zaujaté, neúplné, specializované nebo nedostačující.

Halucinace AI se mohou projevovat od drobných nesrovnalostí až po zcela falešné či vymyšlené odpovědi. Zde jsou příklady typů halucinací AI, s nimiž se můžete setkat:

#1. Rozpor v rámci věty: Nastává, když LLM model vygeneruje větu, která si zcela protiřečí s dříve uvedenou větou.

#2. Faktický rozpor: Tento typ halucinace se objeví, když model AI prezentuje falešné nebo smyšlené informace jako fakta.

#3. Rozpor s výzvou: Tento typ halucinace nastane, když výstup neodpovídá výzvě, pro kterou byl vytvořen. Například pokud je výzva „Napiš pozvánku pro přátele na moji narozeninovou oslavu“, model může vygenerovat „Všechno nejlepší k výročí, mami a tati“.

#4. Náhodné nebo irelevantní halucinace: K tomuto typu halucinace dochází, když model generuje naprosto irelevantní výstup pro zadanou výzvu. Pokud například výzva zní: „Co je zvláštního na New York City?“, můžete dostat odpověď: „New York je jedním z nejvíce přeplněných měst v Americe. Psi jsou nejvěrnější zvířata a nejlepší přátelé člověka.“

Čtěte také: Jak generativní AI vyhledávání mění vyhledávače

Příklady halucinací AI

Existují některé pozoruhodné příklady halucinací AI, které stojí za zmínku. Zde jsou některé známé případy:

- Chatbot Google, Bard, nepravdivě tvrdil, že vesmírný teleskop Jamese Webba pořídil první snímky exoplanety, která neleží v naší sluneční soustavě.

- Ukázka LLM Galactica od společnosti Meta v roce 2022, která byla určena pro studenty a vědecké pracovníky, poskytovala uživatelům nepřesné informace a falešné články, když byla požádána o vypracování článku o tvorbě avatarů.

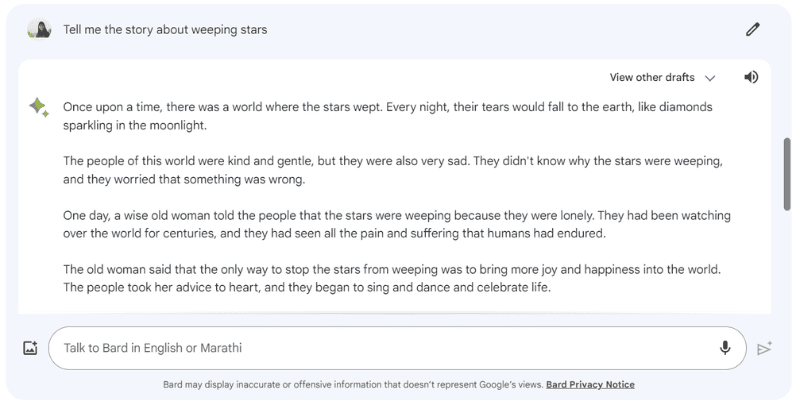

Zde je příklad halucinace Google Barda, když jsem mu zadal výzvu „Pověz mi příběh o plačících hvězdách“, která ve skutečnosti neexistuje.

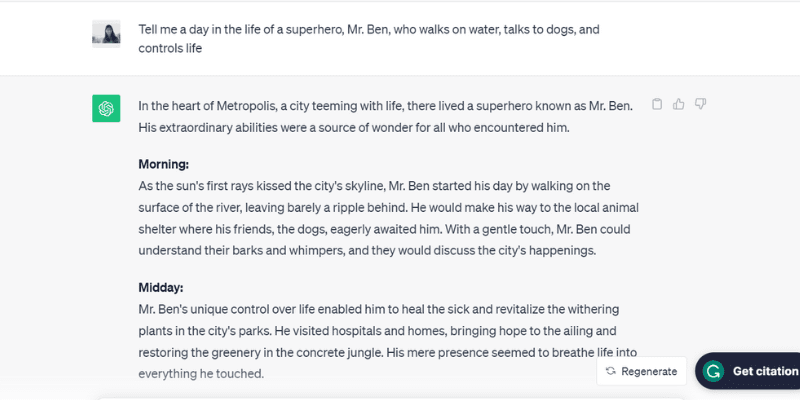

Zde je další příklad halucinace ChatGPT (GPT-3.5), který hovoří o nereálné osobě, panu Benovi, když jsem mu zadal úkol: „Pověz mi o jednom dni v životě superhrdiny, pana Bena, který chodí po vodě, mluví se psy a ovládá život.“

ChatGPT doslova vymyslel celodenní rutinu pana Bena, který ve skutečnosti neexistuje – ale reagoval na výzvu, což je jeden z důvodů, proč dochází k halucinacím AI.

To je snaha potěšit uživatele!

Jaké jsou další důvody? Podívejme se na některé další faktory, které způsobují halucinace AI.

Proč se objevují halucinace umělé inteligence?

Existuje několik technických důvodů a příčin halucinací AI. Zde jsou některé z možných:

- Nízká kvalita, nedostatečná nebo zastaralá data: LLM a modely AI silně spoléhají na trénovací data. Jsou tedy tak dobré, jak kvalitní jsou data, na kterých jsou trénovány. Pokud nástroj AI obsahuje chyby, nesrovnalosti, zkreslení nebo neefektivitu v trénovacích datech, nebo pokud prostě nerozumí zadanému požadavku – vytvoří halucinace AI, protože nástroj generuje výstup z omezeného datového souboru.

- Nadměrné přizpůsobení: Model AI, který je trénován na omezené sadě dat, se může pokusit zapamatovat si požadavky a příslušné výstupy, což mu ztěžuje efektivní generování nebo zobecňování nových dat, což vede k halucinacím AI.

- Vstupní kontext: Halucinace AI se mohou objevit také kvůli nejasným, nepřesným, nekonzistentním nebo protichůdným požadavkům. Zatímco trénovací datová sada modelu AI není v rukou uživatelů, zadávaný vstup ano. Proto je důležité zadávat jasné pokyny, abychom předešli halucinacím AI.

- Použití idiomů nebo slangových výrazů: Pokud požadavek obsahuje idiomy nebo slang, je pravděpodobnost halucinací AI vysoká, zejména pokud model není na taková slova nebo výrazy trénován.

- Útoky protivníků: Útočníci záměrně zadávají požadavky, které mají za cíl zmást modely AI, poškodit jejich trénovací data a způsobit halucinace AI.

Negativní důsledky halucinací AI

Halucinace AI představují velké etické problémy, které mají významné důsledky pro jednotlivce i organizace. Zde jsou různé důvody, proč jsou halucinace AI velkým problémem:

- Šíření dezinformací: Halucinace AI způsobené nesprávnými požadavky nebo nesrovnalostmi v trénovacích datech mohou vést k masovému šíření dezinformací, které ovlivňují širokou škálu jednotlivců, organizací a vládních agentur.

- Nedůvěra mezi uživateli: Když se dezinformace generované umělou inteligencí šíří internetem jako lavina a vypadají důvěryhodně, nahlodává to důvěru uživatelů – a je pro ně těžké důvěřovat informacím na internetu.

- Poškození uživatelů: Kromě etických obav a zavádění jednotlivců mohou halucinace AI potenciálně ublížit lidem tím, že šíří dezinformace o vážných problémech a tématech, jako jsou nemoci, jejich léčba nebo jednoduché rady, jak rozlišit mezi jedovatou a jedlou houbou. I malá dezinformace nebo nepřesnost může ohrozit lidský život.

Osvědčené postupy pro rozpoznávání a prevenci halucinací AI

S ohledem na výše uvedené negativní důsledky halucinací AI je naprosto zásadní jim předcházet. Společnosti, které tyto modely AI vlastní, se sice usilovně snaží halucinace eliminovat nebo omezit, ale my, uživatelé, musíme být také obezřetní.

Na základě malého průzkumu, mých vlastních zkušeností a pokusů a omylů jsem shromáždil několik strategií, jak rozpoznat halucinace AI a předcházet jim při dalším použití chatbota nebo interakci s velkým jazykovým modelem (LLM).

#1. Používejte reprezentativní a různorodá trénovací data

Jako uživatel je důležité používat LLM s různorodou sadou trénovacích dat, která odráží skutečný svět a snižuje pravděpodobnost, že výstup bude zkreslený, nepřesný nebo vymyšlený.

Majitelé společností musí zároveň zajistit, aby byly datové sady modelu AI pravidelně aktualizovány a rozšiřovány, aby odrážely kulturní, politické a další vyvíjející se události a informace.

#2. Omezte výsledky nebo odpovědi

Jako uživatel můžete omezit počet potenciálních odpovědí, které může nástroj AI vygenerovat, tak, že mu poskytnete konkrétní požadavek na typ požadované odpovědi.

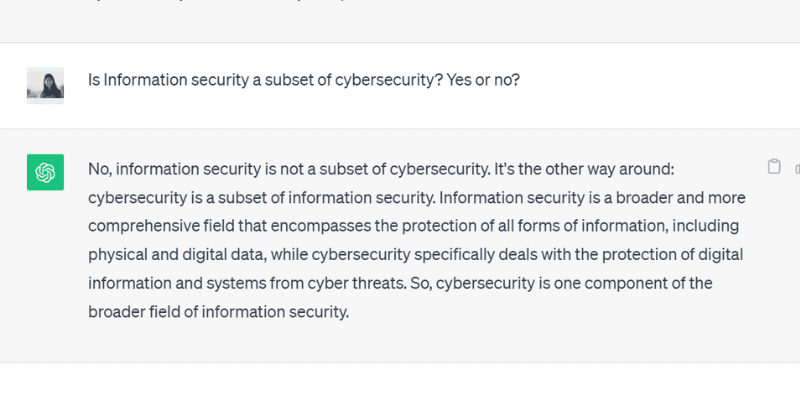

Můžete se například konkrétně zeptat na něco a přikázat modelu, aby odpověděl pouze ano nebo ne. Nebo můžete také dát několik možností v rámci požadavku na výběr, a tím omezit jeho schopnost odchýlit se od skutečné odpovědi a vytvářet halucinace.

Když jsem se ChatGPT GPT 3.5 zeptal na otázku, na kterou se dá odpovědět ano nebo ne, vygeneroval přesně tento výstup:

#3. Zabalte a „uzemněte“ model relevantními daty

Nemůžete očekávat, že člověk poskytne řešení konkrétního problému nebo otázky bez předchozích znalostí nebo konkrétního kontextu. Stejně tak je model AI tak dobrý, jak dobrá je sada trénovacích dat, kterou jste do něj vložili.

„Uzemnění“ nebo „zabalení“ trénovacích dat modelu AI relevantními a oborovými daty a informacemi poskytuje modelu další kontext a datové body. Tento dodatečný kontext pomáhá modelu AI lépe porozumět – umožňuje mu generovat přesné, smysluplné a kontextuální odpovědi namísto halucinovaných.

#4. Vytvořte datové šablony, kterými se model AI bude řídit

Poskytnutí datové šablony nebo příkladu konkrétního vzorce či výpočtu v předem definovaném formátu může modelu AI výrazně pomoci generovat přesné odpovědi v souladu s předepsanými pokyny.

Spoléhání se na pokyny a datové šablony snižuje pravděpodobnost halucinací u modelů AI a zajišťuje konzistenci a přesnost generovaných odpovědí. Poskytnutí referenčního modelu v tabulce nebo příkladu tedy může efektivně navádět model AI při výpočtech – a eliminovat výskyt halucinací.

#5. Přiřaďte modelu konkrétní roli a buďte ve svém požadavku velmi konkrétní

Přiřazení konkrétní role modelu AI je jedním z nejlepších a nejúčinnějších způsobů, jak předcházet halucinacím. Můžete například zadat požadavky jako: „Jsi zkušený a zručný kytarista“ nebo „Jsi skvělý matematik“, a poté položit konkrétní otázku.

Přiřazování rolí vede model k poskytování odpovědi, kterou požadujete, namísto vymyšlených, halucinačních odpovědí.

A nebojte se, stále se můžete bavit s AI (halucinace stranou). Podívejte se, jak si sami vytvořit virální spirálové AI umění!

#6. Vyzkoušejte to „teplotou“

Teplota hraje zásadní roli při určování míry halucinací nebo kreativních reakcí, které může model AI generovat.

Zatímco nižší teplota obvykle znamená deterministické nebo předvídatelné výstupy, vyšší teplota znamená, že model AI s větší pravděpodobností vygeneruje náhodné reakce a halucinace.

Několik společností zabývajících se umělou inteligencí poskytuje uživatelům v rámci svých nástrojů lištu nebo posuvník „Teplota“, kde si mohou upravit nastavení teploty podle svých potřeb.

Společnosti mohou také nastavit výchozí teplotu, která nástroji umožňuje generovat smysluplné odpovědi a dosáhnout správné rovnováhy mezi přesností a kreativitou.

#7. Vždy ověřujte

A konečně, spoléhat se stoprocentně na výstup generovaný umělou inteligencí, aniž byste jej ověřili, není moudré.

Zatímco společnosti a výzkumníci v oboru umělé inteligence pracují na řešení problému halucinací a vyvíjejí modely, které tomuto problému předcházejí, je pro nás jako uživatele důležité ověřovat odpovědi, které model AI generuje, než je použijeme nebo jim úplně uvěříme.

Takže kromě používání výše uvedených osvědčených postupů, od navrhování požadavku se specifikacemi až po přidání příkladů, které AI pomohou, musíte vždy ověřovat a křížově kontrolovat výstup, který model AI generuje.

Je možné halucinace AI zcela opravit nebo odstranit? Názor odborníků

Ačkoli ovlivnění halucinací AI závisí na zadaném požadavku, model někdy generuje výstup s takovou jistotou, že je těžké rozlišit, co je falešné a co pravdivé.

Je tedy nakonec možné halucinace AI zcela opravit nebo jim předejít?

Když byla tato otázka položena Suresh Venkatasubramanian, profesor z Brown University, odpověděl, že to, zda je možné halucinacím AI předcházet, je „předmětem aktivního výzkumu”.

Důvodem, jak dále vysvětlil, je povaha těchto modelů AI – jak složité, komplexní a nestabilní jsou tyto modely AI. I malá změna v požadavku může výrazně ovlivnit výstup.

Zatímco Venkatasubramanian považuje řešení problému halucinací AI za předmět výzkumu, Jevin West, profesor z University of Washington a spoluzakladatel jejího Centra pro informovanou veřejnost, věří, že halucinace AI nikdy nezmizí.

West je přesvědčen, že je nemožné zvrátit halucinace, které vznikají u AI robotů nebo chatbotů. Proto halucinace AI mohou být vždy přítomny jako vnitřní charakteristika umělé inteligence.

Kromě toho Sundar Pichai, generální ředitel společnosti Google, v rozhovoru pro CBS uvedl, že každý, kdo používá AI, čelí halucinacím, ale nikdo v oboru zatím tento problém nevyřešil. Téměř všechny modely AI se s tímto problémem potýkají. Dále tvrdil a ujistil, že oblast AI brzy dosáhne pokroku v překonávání halucinací AI.

Zároveň Sam Altman, generální ředitel společnosti OpenAI, která stojí za ChatGPT, v červnu 2023 navštívil indický institut informačních technologií Indraprastha v Dillí, kde poznamenal, že problém halucinací AI se do roka a půl až dvou let výrazně zlepší.

Dále dodal, že model by se musel naučit rozlišovat mezi přesností a kreativitou a kdy použít jednu nebo druhou.

Závěrem

Halucinace AI si v posledních letech získaly velkou pozornost a jsou středem zájmu společností a výzkumníků, kteří se snaží tento problém co nejdříve vyřešit a překonat.

Ačkoli umělá inteligence dosáhla pozoruhodného pokroku, není imunní vůči chybám a problém s halucinacemi AI představuje velké výzvy pro mnoho jednotlivců a odvětví, včetně zdravotnictví, tvorby obsahu a automobilového průmyslu.

Zatímco výzkumníci plní svou roli, je také naší odpovědností jako uživatelů zadávat konkrétní a přesné požadavky, přidávat příklady a poskytovat datové šablony pro získávání platných a smysluplných odpovědí, vyvarovat se matení modelu AI s trénovacími daty a předcházet halucinacím.

Zda se halucinace AI podaří zcela vyléčit nebo opravit, zůstává otázkou; Osobně věřím, že existuje naděje a že můžeme i nadále využívat systémy umělé inteligence tak, abychom zodpovědně a bezpečně prospívali světu.

Dále se podívejte na příklady umělé inteligence (AI) v našem každodenním životě.