Pro lidi, kteří nejsou obeznámeni s kódováním, může být vytvoření webového škrabáku obtížné. Naštěstí je web scraping software dostupný pro programátory i neprogramátory. Web scraping software je speciálně navržený software pro získávání relevantních dat z webových stránek. Tyto nástroje jsou výhodné pro každého, kdo chce nějakým způsobem získávat data z internetu. Tyto informace jsou zaznamenány v místním souboru v počítači nebo v databázi. Je to technika autonomního sběru dat pro web. Přinášíme seznam 31 nejlepších bezplatných nástrojů pro škrábání webu.

Table of Contents

31 nejlepších nástrojů pro škrábání webu

Vybraný seznam nejlepších nástrojů pro škrábání webu naleznete zde. Tento seznam obsahuje komerční i open-source nástroje a také odkazy na příslušné webové stránky.

1. Přelstít

Outwit je doplněk Firefoxu, který se snadno instaluje z obchodu s doplňky Firefoxu.

- Díky tomuto nástroji pro škrabání dat je shromažďování kontaktů z webu a prostřednictvím e-mailu hračkou.

- V závislosti na vašich požadavcích budete mít tři alternativy nákupu tohoto produktu.

- Pro

-

Expert a

-

K dispozici jsou edice Enterprise.

- Přesná data ze stránek pomocí centra Outwit nevyžaduje žádné znalosti programování.

- Jediným kliknutím na tlačítko prozkoumání můžete začít prohledávat stovky webových stránek.

2. PareseHub

ParseHub je další z nejlepších bezplatných nástrojů pro škrábání webu.

- Před stažením dat očistěte text a HTML.

- Je to stejně jednoduché jako výběr dat, která chcete extrahovat, pomocí naší sofistikované webové škrabky.

- Je to jeden z nejlepších nástrojů pro seškrabování dat, protože vám umožňuje ukládat seškrabovaná data v jakémkoli formátu pro další analýzu.

- Uživatelsky přívětivé grafické rozhraní

- Tento internetový škrabací nástroj vám umožňuje automaticky sklízet a ukládat data na servery.

3. Apify

Apify je dalším z nejlepších nástrojů pro stírání a automatizaci webu, který vám umožňuje vytvořit API pro jakýkoli web s vestavěnými proxy pro rezidenční a datová centra, které usnadňují extrakci dat.

- Apify se stará o infrastrukturu a fakturaci a umožňuje vývojářům vydělávat pasivní peníze navrhováním nástrojů pro ostatní.

- Některé z dostupných konektorů jsou Zapier, Integromat, Keboola a Airbyte.

- Apify Store má hotová řešení scrapingu pro oblíbené weby, jako je Instagram, Facebook, Twitter a Mapy Google.

- JSON, XML, CSV, HTML a Excel jsou strukturované formuláře, které lze stáhnout.

- HTTPS, geolokační cílení, chytré střídání IP adres a proxy servery Google SERP jsou všechny funkce Apify Proxy.

- Bezplatná 30denní zkušební verze proxy s kreditem platformy 5 USD.

4. Scrapestack

Scrapestack používá více než 2000 firem a spoléhají na toto jedinečné API, které je poháněno apilayerem. Je to jeden z nejlepších bezplatných nástrojů pro škrábání webu.

- Využívá celosvětový fond IP adres 35 milionů datových center.

- Umožňuje provádět mnoho požadavků API najednou.

- Podporováno je jak dešifrování CAPTCHA, tak vykreslování JavaScriptu.

- K dispozici jsou bezplatné i placené možnosti.

- Scrapestack je online škrabací REST API, které funguje v reálném čase.

- Scrapestack API vám umožňuje škrábat webové stránky během milisekund pomocí milionů proxy IP, prohlížečů a CAPTCHA.

- Žádosti o stírání webu lze odesílat z více než 100 různých míst po celém světě.

5. FMiner

Pro Windows a Mac OS je FMiner populární online program pro škrábání, extrakci dat, škrábání obrazovky procházení, makro a webovou podporu.

- Data mohou být shromažďována z dynamických webových stránek Web 2.0, které se obtížně procházejí.

- Umožňuje vytvořit projekt extrakce dat pomocí vizuálního editoru, který se snadno používá.

- Používá kombinaci struktur odkazů, rozevíracích nabídek a porovnávání vzorů adres URL, abyste se mohli prohrabovat webovými stránkami.

- K cílení ochrany webu pomocí CAPTCHA můžete použít automatické decaptcha služby třetích stran nebo ruční zadání.

6. Sequentum

Sequentum je robustní nástroj pro velká data pro získávání důvěryhodných online dat. Je to další z nejlepších bezplatných nástrojů pro škrábání webu.

- Ve srovnání s alternativními řešeními je získávání online dat stále rychlejší.

- Pomocí této funkce můžete přecházet mezi více platformami.

- Je to jeden z nejúčinnějších webových škrabáků pro růst vaší společnosti. Obsahuje přímočaré funkce včetně vizuálního editoru point-and-click.

- Vyhrazené webové rozhraní API vám pomůže při vývoji webových aplikací tím, že vám umožní spouštět webová data přímo z vašeho webu.

7. Agentura

Agenty je program pro škrábání dat, extrakci textu a OCR, který využívá automatizaci robotických procesů.

- Tento program vám umožňuje znovu použít všechna vaše zpracovaná data pro účely analýzy.

- Agenta můžete sestavit pouze několika kliknutími myši.

- Po dokončení úkolu obdržíte e-mailovou zprávu.

- Umožňuje vám připojit se k Dropboxu a používat zabezpečené FTP.

- Všechny protokoly aktivit pro všechny výskyty jsou k dispozici k zobrazení.

- Pomůže vám zlepšit úspěch vaší společnosti.

- Umožňuje snadno implementovat obchodní pravidla a vlastní logiku.

8. Import.io

Importem dat z určité webové stránky a exportem dat do CSV vám aplikace import.io web scraping pomáhá při vytváření vašich datových sad. Je to také jeden z nejlepších nástrojů pro škrábání webu. Níže jsou uvedeny vlastnosti tohoto nástroje.

- Webové formuláře/přihlášení se snadno používají.

- Je to jedno z nejlepších řešení pro odstraňování dat pro využití rozhraní API a webhooků k integraci dat do aplikací.

- Přehled můžete získat prostřednictvím sestav, grafů a vizualizací.

- Extrakce dat by měla být plánována předem.

- Cloud Import.io umožňuje ukládat data a přistupovat k nim.

- Interakci s webem a pracovními postupy lze automatizovat.

9. Webz.io

Webz.io vám umožňuje procházet stovky webových stránek a mít okamžitý přístup ke strukturovaným datům v reálném čase. Je to také jeden z nejlepších bezplatných nástrojů pro škrábání webu.

Můžete získat organizované, strojově čitelné datové sady ve formátech JSON a XML.

- Poskytuje vám přístup k historickým zdrojům, které pokrývají data za více než deset let.

- Umožňuje vám mít přístup k velké databázi datových zdrojů, aniž byste museli platit další výdaje.

- Můžete použít pokročilý filtr k provedení podrobné analýzy a datových sad zdroje.

10. Škrabadlo

Scrape Owl je platforma pro škrábání webu, která se snadno používá a je ekonomická.

- Primárním cílem Scrape Owl je seškrábat jakýkoli typ dat, včetně elektronického obchodu, pracovních tabulek a seznamů nemovitostí.

- Před extrahováním materiálu můžete spustit vlastní JavaScript.

- Umístění můžete používat k obcházení místních omezení a přístupu k místnímu obsahu.

- Poskytuje spolehlivou funkci čekání.

- Je podporováno celostránkové vykreslování JavaScriptu.

- Tuto aplikaci lze použít přímo v Tabulce Google.

- Nabízí bezplatnou zkušební verzi 1000 kreditů k vyzkoušení služby před zakoupením jakéhokoli členství. Není potřeba používat kreditní kartu.

11. Scrapingbee

Scrapingbee je webové škrabací API, které se stará o nastavení proxy a bezhlavé prohlížeče.

- Může spouštět Javascript na stránkách a střídat proxy pro každý požadavek, takže můžete číst nezpracovaný HTML, aniž byste se dostali na černou listinu.

- K dispozici je také druhé rozhraní API pro extrahování výsledků vyhledávání Google.

- Je podporováno vykreslování JavaScriptu.

- Má funkci automatické rotace proxy.

- Tuto aplikaci lze používat přímo v Tabulkách Google.

- K používání programu je nutný webový prohlížeč Chrome.

- Je ideální pro škrábání Amazonu.

- Umožňuje vám seškrábat výsledky Google.

12. Jasná data

Bright Data je přední světová online datová platforma, která nabízí nákladově efektivní řešení pro shromažďování veřejných webových dat ve velkém měřítku, snadnou konverzi nestrukturovaných dat na strukturovaná data a poskytuje vynikající zákaznickou zkušenost, přičemž je plně transparentní a v souladu s předpisy.

- Je nejvíce přizpůsobitelný, protože přichází s předem připravenými řešeními a je rozšiřitelný a nastavitelný.

- Kolektor dat nové generace Bright Data poskytuje automatizovaný a personalizovaný tok dat na jediném řídicím panelu, bez ohledu na velikost kolekce.

- Je otevřená 24 hodin denně, sedm dní v týdnu a nabízí zákaznickou asistenci.

- Od trendů eCommerce a dat ze sociálních sítí až po konkurenční zpravodajství a průzkum trhu, datové soubory jsou přizpůsobeny potřebám vaší firmy.

- Automatizací přístupu ke spolehlivým datům ve vašem oboru se můžete soustředit na svůj primární byznys.

- Je nejúčinnější, protože používá řešení bez kódu a využívá méně zdrojů.

- Nejspolehlivější, s nejkvalitnějšími daty, vyšší dobou provozuschopnosti, rychlejšími daty a lepšími službami zákazníkům.

13. Scraper API

Ke zpracování proxy serverů, prohlížečů a obrázků CAPTCHA můžete použít nástroj Scraper API.

- Tento nástroj poskytuje bezkonkurenční rychlost a spolehlivost, což umožňuje vytvářet škálovatelné webové škrabky.

- HTML můžete získat z jakékoli webové stránky pomocí jediného volání API.

- Nastavení je snadné, protože vše, co musíte udělat, je odeslat požadavek GET s vaším klíčem API a adresou URL do koncového bodu API.

- Umožňuje snadnější vykreslování JavaScriptu.

- Umožňuje vám přizpůsobit typ požadavku a záhlaví pro každý požadavek.

- Rotující proxy s geografickou polohou

14. Dexi Intelligent

Dexi intelligent je online scrapingová aplikace, která vám umožňuje přeměnit jakékoli množství webových dat na rychlou komerční hodnotu.

- Tento online škrabací nástroj vám umožní ušetřit peníze a čas vaší společnosti.

- Zvýšila produktivitu, přesnost a kvalitu.

- Umožňuje nejrychlejší a nejefektivnější extrakci dat.

- Má rozsáhlý systém zachycování znalostí.

15. Diffbot

Diffbot vám umožňuje rychle získat řadu důležitých faktů z internetu.

- S AI extraktory budete moci extrahovat přesná strukturovaná data z libovolné adresy URL.

- Nebudou vám účtovány poplatky za časově náročné vyhledávání webových stránek nebo ruční dotazování.

- Pro vytvoření úplného a přesného obrazu každého objektu je sloučeno mnoho zdrojů dat.

- Pomocí AI Extractors můžete extrahovat strukturovaná data z libovolné adresy URL.

- S Crawlbotem můžete rozšířit extrakci na desítky tisíc domén.

- Funkce Knowledge Graph poskytuje webu přesná, úplná a hluboká data, která BI potřebuje k poskytování smysluplných přehledů.

16. Datový streamer

Data Streamer je technologie, která vám umožňuje získávat materiál sociálních sítí z celého internetu.

- Je to jeden z největších online scraperů, který využívá zpracování přirozeného jazyka k načtení klíčových metadat.

-

Kibana a Elasticsearch se používají k poskytování integrovaného fulltextového vyhledávání.

- Založeno na algoritmech získávání informací, integrovaném odstraňování standardního obsahu a extrakci obsahu.

- Postaveno na infrastruktuře odolné proti chybám, která poskytuje vysokou dostupnost informací.

17. Mozenda

Pomocí Mozendy můžete extrahovat text, fotografie a materiály PDF z webových stránek.

- Ke shromažďování a publikování online dat můžete použít svůj vybraný nástroj Bl nebo databázi.

- Je to jeden z nejlepších online škrabacích nástrojů pro organizaci a formátování datových souborů pro publikování.

- S rozhraním typu point-and-click můžete vytvořit webové škrabací agenty během několika minut.

- Chcete-li shromažďovat webová data v reálném čase, použijte funkce Job Sequencer a Request Blocking.

- Správa účtů a zákaznický servis patří k nejlepším v oboru.

18. Rozšíření Data Miner pro Chrome

Web scraping a sběr dat jsou snazší s pluginem prohlížeče Data Miner.

- Má schopnost procházet několik stránek a také dynamickou extrakci dat.

- Výběr dat lze provádět různými způsoby.

- Zkoumá informace, které byly seškrábány.

- It Data seškrábaná lze uložit jako soubor CSV.

- Místní úložiště se používá k ukládání seškrabovaných dat.

- Doplněk Web Scraper pro Chrome stahuje data z dynamických webů.

- it Soubory Sitemap lze importovat a exportovat.

19. Odřený

Scrapy je také jedním z nejlepších nástrojů pro škrábání webu. Jedná se o open-source online scraping framework založený na Pythonu pro vytváření webových scraperů.

- Poskytuje vám všechny nástroje, které budete potřebovat k rychlému extrahování dat z webových stránek, jejich analýze a uložení ve struktuře a formátu podle vašeho výběru.

- Tento nástroj pro škrabání dat je nutností, pokud máte velký projekt škrabání dat a chcete jej maximálně zefektivnit a zároveň zachovat velkou flexibilitu.

- Data lze exportovat jako JSON, CSV nebo XML.

- Podporovány jsou Linux, Mac OS X a Windows.

- Je vyvinut nad technologií asynchronních sítí Twisted, což je jedna z jeho klíčových vlastností.

- Scrapy je pozoruhodný svou jednoduchostí použití, rozsáhlou dokumentací a aktivní komunitou.

20. ScrapeHero Cloud

ScrapeHero využil své letité znalosti procházení webu a proměnil je v ekonomické a snadno použitelné předem sestavené prohledávače a API pro seškrabování dat ze stránek jako Amazon, Google, Walmart a další.

- Cloudové prohledávače ScrapeHero zahrnují automaticky rotující proxy a možnost spouštět mnoho prohledávačů současně.

- Abyste mohli používat ScrapeHero Cloud, nemusíte si stahovat ani se učit, jak používat žádné nástroje nebo software pro škrabání dat.

- Prohledávače ScrapeHero Cloud vám umožňují okamžitě seškrábat data a exportovat je ve formátech JSON, CSV nebo Excel.

- Klienti bezplatného a jednoduchého tarifu ScrapeHero Cloud dostávají e-mailovou asistenci, zatímco všechny ostatní plány dostávají službu Priority.

- Prohledávače ScrapeHero Cloud mohou být také nakonfigurovány tak, aby splňovaly specifické požadavky zákazníků.

- Je to webový škrabák založený na prohlížeči, který funguje s jakýmkoli webovým prohlížečem.

- Nepotřebujete žádné znalosti programování ani vývoj scraperu; je to stejně snadné jako klikání, kopírování a vkládání!

21. Škrabka dat

Data Scraper je bezplatná online škrabací aplikace, která stahuje data z jedné webové stránky a ukládá je jako soubory CSV nebo XSL.

- Je to rozšíření prohlížeče, které převádí data do úhledného tabulkového formátu.

- Instalace pluginu vyžaduje použití prohlížeče Google Chrome.

- S bezplatnou verzí můžete každý měsíc seškrábat 500 stránek; ale pokud chcete seškrábat více stránek, musíte upgradovat na jeden z drahých plánů.

22. Visual Web Ripper

Visual Web Ripper je nástroj pro automatické škrábání dat pro webové stránky.

- Pomocí tohoto nástroje se shromažďují datové struktury z webových stránek nebo výsledků vyhledávání.

- Data můžete exportovat do souborů CSV, XML a Excel a nabízí uživatelsky přívětivé rozhraní.

- Může také sklízet data z dynamických webových stránek, jako jsou ty, které používají AJAX.

- Stačí nastavit několik šablon a webová škrabka se postará o zbytek.

- Visual Web Ripper nabízí možnosti plánování a dokonce vám pošle e-mail, pokud projekt selže.

23. Octoparse

Octoparse je uživatelsky přívětivá aplikace pro škrábání webových stránek s vizuálním rozhraním. Je to jeden z nejlepších bezplatných nástrojů pro škrábání webu. Níže jsou uvedeny vlastnosti tohoto nástroje.

- Jeho rozhraní typu point-and-click usnadňuje výběr informací, které chcete z webové stránky získat. Octoparse zvládne statické i dynamické webové stránky díky AJAX, JavaScript, cookies a dalším možnostem.

- Nyní jsou dostupné pokročilé cloudové služby, které umožňují extrahovat velké množství dat.

- Stažené informace lze uložit jako soubory TXT, CSV, HTML nebo XLSX.

- Bezplatná verze Octoparse vám umožňuje postavit až 10 prohledávačů; plány placeného členství však zahrnují funkce, jako je API a velký počet anonymních IP proxy, které urychlí vaši extrakci a umožní vám stahovat velké objemy dat v reálném čase.

24. Web Harvey

Vizuální webový škrabák WebHarvey má vestavěný prohlížeč pro škrábání dat z online stránek. Je to také jeden z nejlepších nástrojů pro škrábání webu. Zde je několik funkcí tohoto nástroje.

- Nabízí rozhraní typu point-and-click, které usnadňuje výběr položek.

- Tato škrabka má tu výhodu, že nevyžaduje psaní žádného kódu.

-

K uložení dat lze použít soubory CSV, JSON a XML.

- Je také možné jej uložit do SQL databáze. WebHarvey obsahuje víceúrovňovou funkci stírání kategorií, která dokáže seškrabovat data ze stránek se seznamy sledováním jednotlivých úrovní připojení kategorií.

- Regulární výrazy mohou být použity s internetovým škrabacím nástrojem, což vám dává další svobodu.

- Můžete nastavit proxy servery, které udrží vaši IP skrytou při stahování dat z webových stránek, což vám umožní zachovat určitou míru soukromí.

25. PySpider

PySpider je také jedním z nejlepších bezplatných nástrojů pro škrábání webu, což je webový prohledávač založený na Pythonu. Níže je uvedeno několik funkcí tohoto nástroje.

- Vyznačuje se distribuovanou architekturou a podporuje stránky Javascript.

- Tímto způsobem můžete mít mnoho prohledávačů. PySpider může ukládat data na libovolném backendu, který si vyberete, včetně MongoDB, MySQL, Redis a dalších.

- K dispozici jsou fronty zpráv jako RabbitMQ, Beanstalk a Redis.

- Jednou z výhod PySpideru je jeho jednoduché uživatelské rozhraní, které vám umožňuje měnit skripty, sledovat běžící aktivity a zkoumat výsledky.

- Informace lze stáhnout ve formátech JSON a CSV.

- PySpider je internetová stránka, kterou je třeba zvážit, pokud pracujete s uživatelským rozhraním založeným na webových stránkách.

- Funguje také s weby, které hodně využívají AJAX.

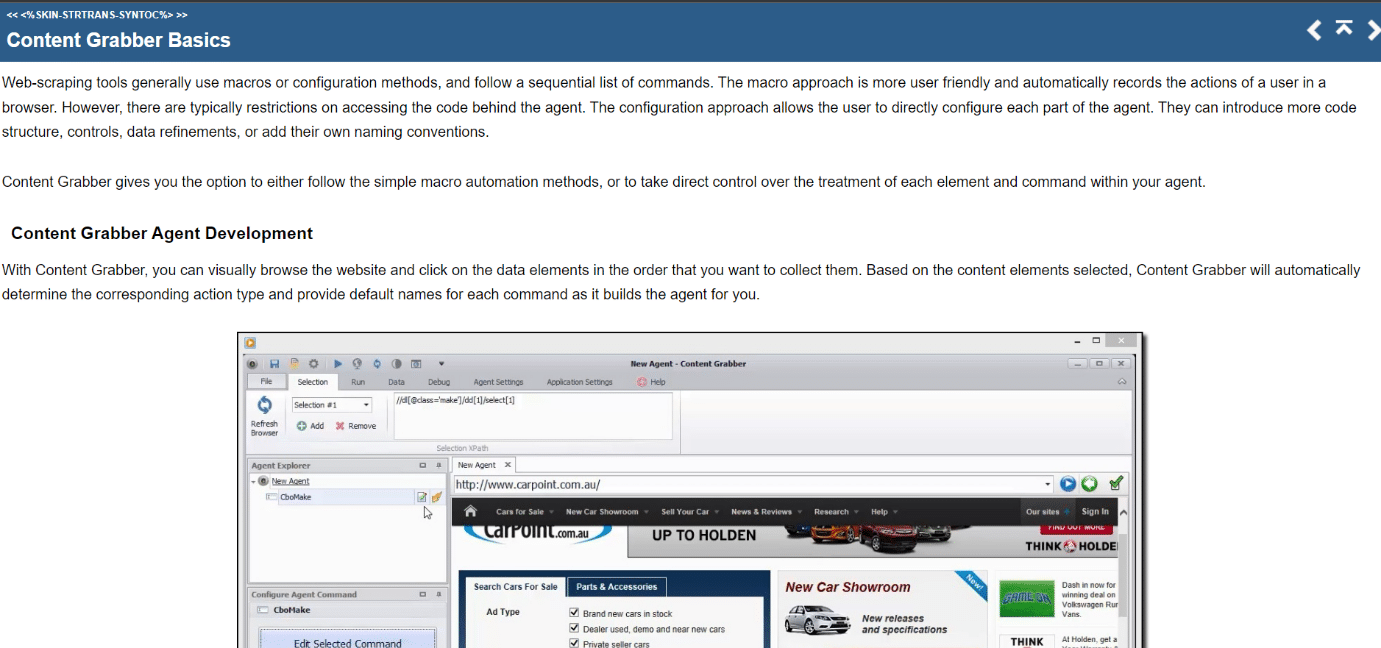

26. Obsah Grabber

Content Grabber je vizuální online škrabací nástroj se snadno použitelným rozhraním point-and-click pro výběr položek. Níže jsou uvedeny vlastnosti tohoto nástroje.

- CSV, XLSX, JSON a PDF jsou formáty, ve kterých lze data exportovat. Pro použití tohoto nástroje jsou vyžadovány středně pokročilé znalosti programování.

- Jeho uživatelské rozhraní umožňuje stránkování, neomezené posouvání stránek a vyskakovací okna.

- Obsahuje také zpracování AJAX/Javascript, řešení captcha, podporu regulárních výrazů a rotaci IP (pomocí Nohodo).

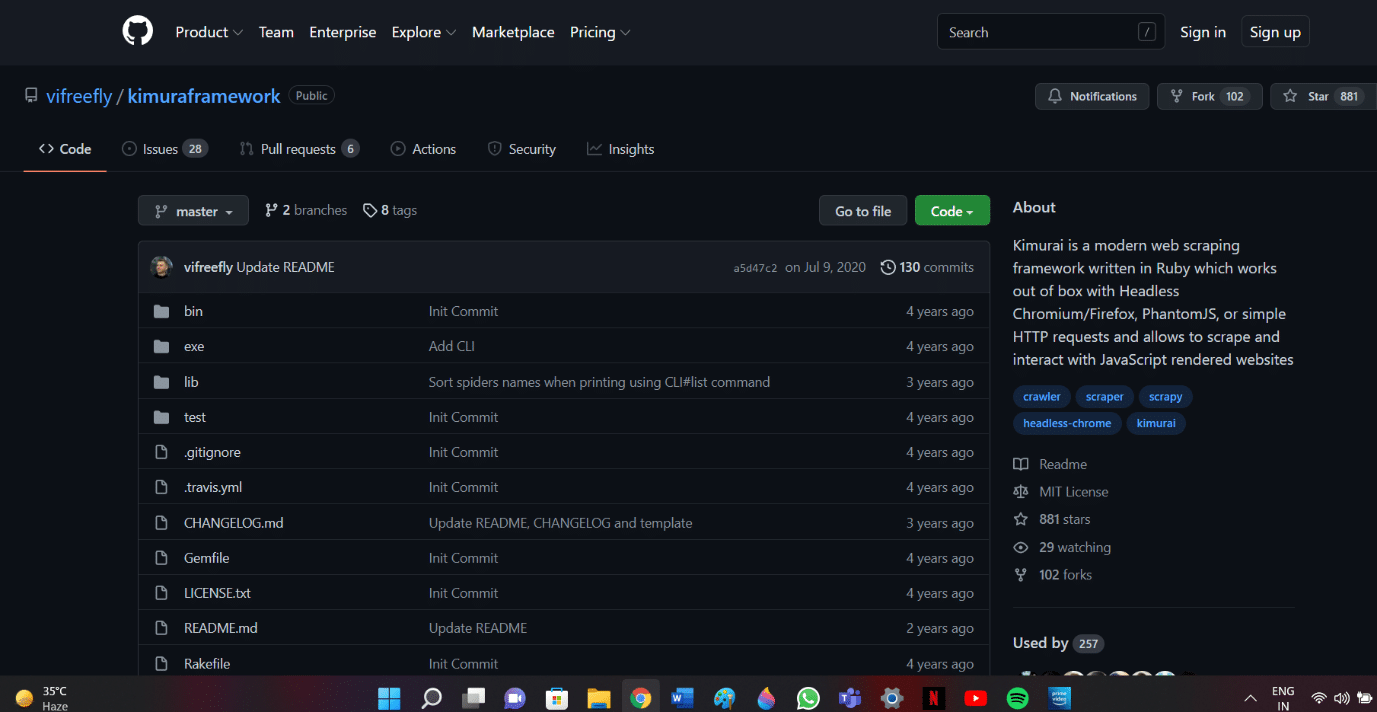

27. Kimurai

Kimurai je Ruby web scraping framework pro vytváření scraperů a extrahování dat. Je to také jeden z nejlepších bezplatných nástrojů pro škrábání webu. Zde je několik funkcí tohoto nástroje.

- Umožňuje nám to škrábat a interagovat s webovými stránkami vytvořenými v JavaScriptu hned po vybalení pomocí Headless Chromium/Firefox, PhantomJS nebo základních HTTP dotazů.

- Má podobnou syntaxi jako Scrapy a konfigurovatelné možnosti včetně nastavení zpoždění, rotace uživatelských agentů a výchozích záhlaví.

- Interaguje také s webovými stránkami pomocí testovacího rámce Capybara.

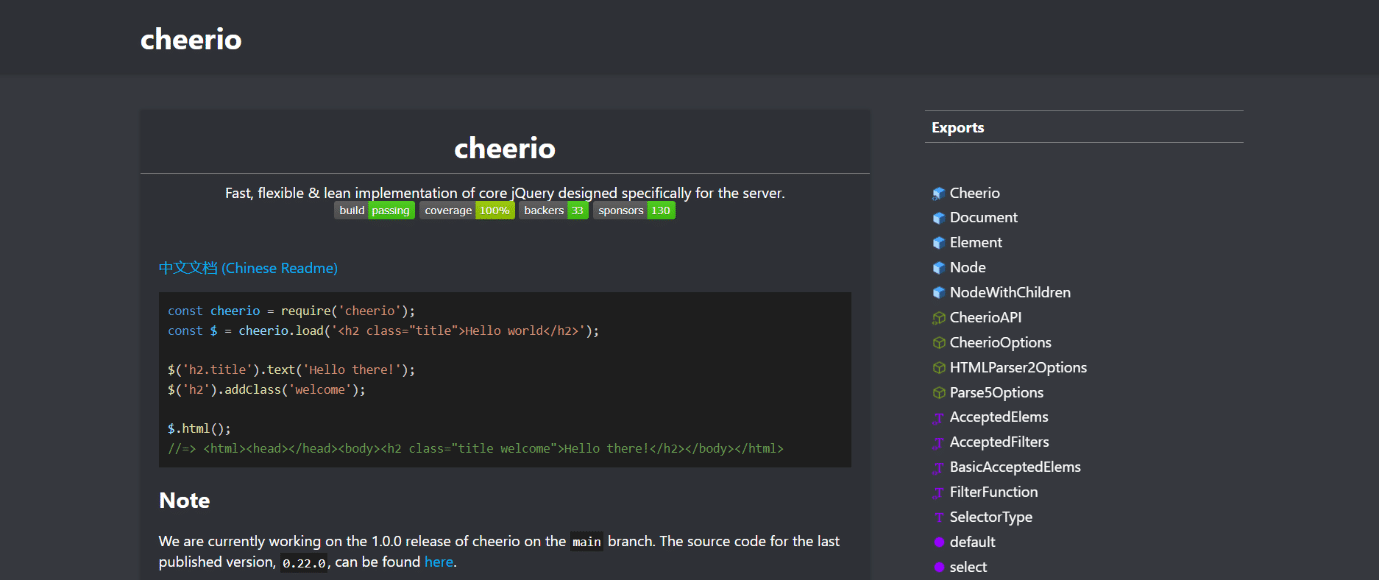

28. Cheerio

Cheerio je další z nejlepších nástrojů pro škrábání webu. Jedná se o balíček, který analyzuje HTML a XML dokumenty a umožňuje pracovat se staženými daty pomocí syntaxe jQuery. Níže jsou uvedeny vlastnosti tohoto nástroje.

- Pokud vyvíjíte JavaScript web scraper, Cheerio API poskytuje rychlou volbu pro analýzu, úpravu a zobrazení dat.

- Nezobrazuje výstup ve webovém prohlížeči, nepoužívá CSS, nenačítá externí zdroje ani nespouští JavaScript.

- Pokud je některá z těchto funkcí vyžadována, měli byste se podívat na PhantomJS nebo JSDom.

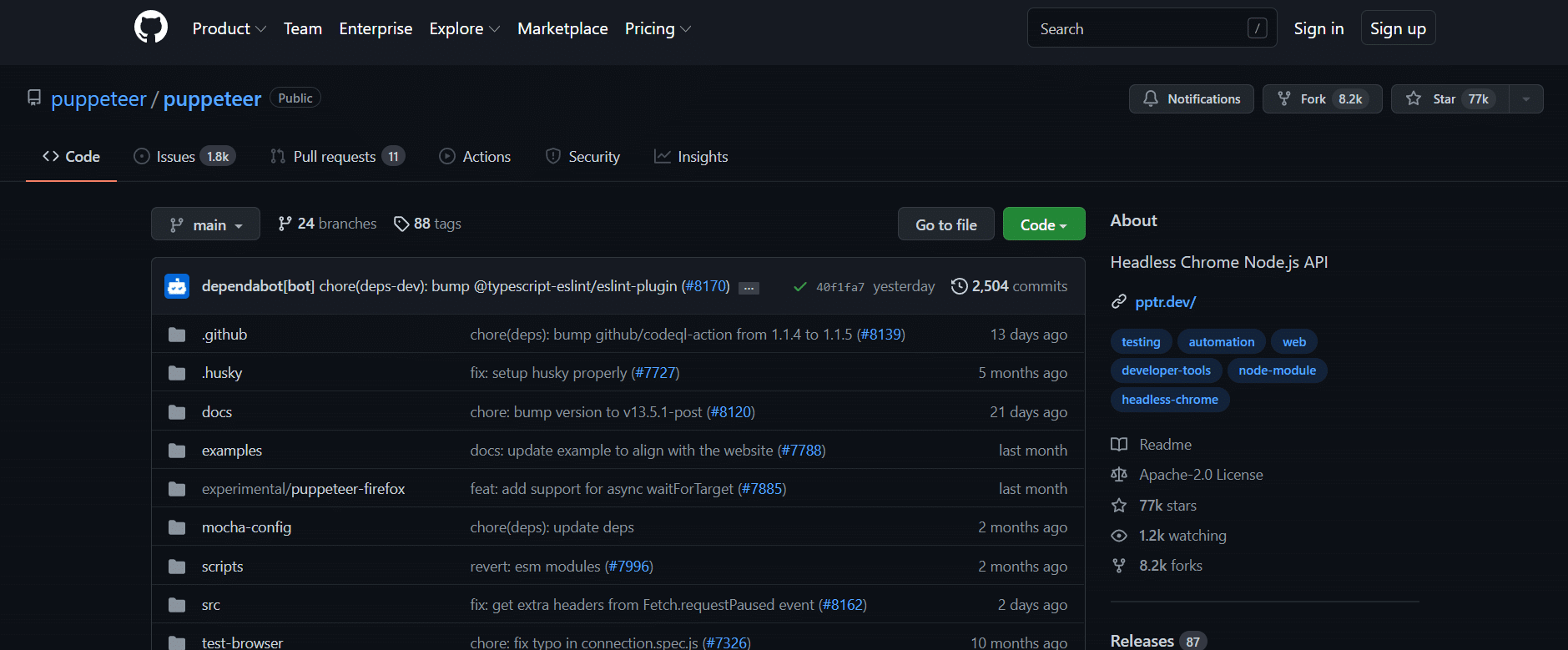

29. Loutkář

Puppeteer je balíček Node, který vám umožňuje spravovat bezhlavý prohlížeč Chrome společnosti Google pomocí výkonného, ale jednoduchého rozhraní API. Níže je uvedeno několik funkcí tohoto nástroje.

- Běží na pozadí a provádí příkazy prostřednictvím API.

- Bezhlavý prohlížeč je takový, který je schopen odesílat a přijímat požadavky, ale postrádá grafické uživatelské rozhraní.

- Puppeteer je tím správným řešením pro daný úkol, pokud jsou informace, které hledáte, generovány pomocí kombinace dat API a kódu Javascript.

- Uživatelské prostředí můžete napodobit psaním a klikáním na stejná místa jako oni.

- Puppeteer lze také použít k zachycení snímků obrazovky webových stránek, které se ve výchozím nastavení zobrazují při otevření webového prohlížeče.

30. Dramatik

Playwright je knihovna Microsoft Node určená pro automatizaci prohlížeče. Je to další z nejlepších bezplatných nástrojů pro škrábání webu. Zde je několik funkcí tohoto nástroje.

- Nabízí kompetentní, spolehlivou a rychlou automatizaci webu napříč prohlížeči.

- Playwright měl zlepšit automatizované testování uživatelského rozhraní odstraněním nestálosti, zvýšením rychlosti provádění a poskytnutím náhledu na to, jak prohlížeč funguje.

- Je to moderní aplikace pro automatizaci prohlížeče, která je v mnoha ohledech srovnatelná s Puppeteerem a je dodávána s předinstalovanými kompatibilními prohlížeči.

- Jeho hlavní výhodou je kompatibilita mezi různými prohlížeči, protože může spouštět Chromium, WebKit a Firefox.

- Playwright se pravidelně integruje s Docker, Azure, Travis CI a AppVeyor.

31. PJScrape

PJscrape je online sada nástrojů pro škrábání založená na Pythonu, která používá Javascript a JQuery. Níže jsou uvedeny vlastnosti tohoto nástroje.

- Je navržen tak, aby spolupracoval s PhantomJS, takže můžete stránky seškrabovat z příkazového řádku v plně vykresleném kontextu s podporou Javascriptu, aniž byste potřebovali prohlížeč.

- To znamená, že máte přístup nejen k DOM, ale také k proměnným a funkcím Javascriptu, stejně jako k obsahu načtenému AJAXem.

- Funkce škrabky se posuzují v kontextu celého prohlížeče.

***

Doufáme, že vám tato příručka pomohla ohledně nejlepších nástrojů pro škrábání webu. Dejte nám vědět, který nástroj je pro vás snadný. Navštivte naši stránku, kde najdete další skvělé tipy a triky, a zanechte své komentáře níže.