Dopad algoritmických zkreslení na náš život

Algoritmické zkreslení se může významně promítat do rozličných aspektů našich životů. Ovlivňuje nás při získávání návrhů online obsahu, při hledání pracovních příležitostí i při rozhodování o financích.

Lidská přirozenost je ovlivněna subjektivitou. Každý jedinec se liší pohlavím, rasou, původem, vzděláním, kulturou, přesvědčením a zkušenostmi. Tyto odlišnosti formují naše názory, myšlenky, sympatie, antipatie a preference. V důsledku toho můžeme získat určité předsudky vůči specifickým skupinám nebo naopak.

Bohužel, stroje nejsou výjimkou. Také oni mohou interpretovat lidi, události a objekty různě, což je způsobeno zkreslením zavedeným v jejich algoritmech. Tyto předsudky mohou vést k tomu, že systémy umělé inteligence a strojového učení generují nespravedlivé výsledky, které negativně ovlivňují životy mnoha lidí.

V tomto textu se budeme věnovat definici algoritmických zkreslení, jejich jednotlivým druhům, a také způsobům, jak je detekovat a minimalizovat. Cílem je dosáhnout větší spravedlnosti v generovaných výsledcích.

Začněme!

Co přesně jsou algoritmické zkreslení?

Algoritmické zkreslení označuje tendenci algoritmů strojového učení a umělé inteligence odrážet lidské předsudky a produkovat nespravedlivé výstupy. Tyto předsudky se mohou týkat pohlaví, věku, rasy, náboženství, etnického původu, kultury a mnoha dalších aspektů.

V kontextu umělé inteligence a strojového učení představuje algoritmické zkreslení systematické, opakující se chyby v zavedených systémech, které vedou k neobjektivním výsledkům.

Zkreslení v algoritmech může být zapříčiněno mnoha faktory, například rozhodnutím při sběru dat, jejich výběru, kódování, použití během tréninku algoritmu, dále pak zamýšleným použitím, samotnou strukturou algoritmu atd.

Příklad: V rámci výsledků vyhledávače můžeme pozorovat zkreslení algoritmů, které má za následek narušování soukromí či prohlubování sociálních předsudků.

Algoritmická zaujatost se projevuje v mnoha oblastech, od volebních výsledků, šíření nenávistných projevů na internetu, přes zdravotnictví, trestní soudnictví až po nábor zaměstnanců. Dochází tak ke kumulaci již existujících předsudků v oblasti pohlaví, rasy, ekonomiky a společnosti.

Typy algoritmických zkreslení

#1. Zkreslení dat

Ke zkreslení dat dochází, když data používaná k trénování modelů umělé inteligence přesně nereprezentují reálné situace či populace. To může vést k nevyváženým nebo zkresleným datovým souborům.

Zdroj: Mezinárodní společnost TELUS

Příklad: Pokud je software pro rozpoznávání obličeje trénován převážně na bílé populaci, může selhávat při rozpoznávání lidí s tmavším odstínem pleti, což je ovlivňuje.

#2. Zkreslení měření

Toto zkreslení se může objevit kvůli chybám v procesu měření nebo sběru dat.

Příklad: Při trénování diagnostického algoritmu pro zdravotnictví, který detekuje onemocnění na základě určitých ukazatelů, například předchozích návštěv lékaře, může dojít ke zkreslení úsudku. Skutečné symptomy onemocnění mohou být opomenuty.

#3. Zkreslení modelu

Zkreslení modelu vzniká při navrhování samotného algoritmu nebo modelu umělé inteligence.

Příklad: Představme si systém umělé inteligence, jehož algoritmus je navržen tak, aby maximalizoval zisk bez ohledu na způsob. Tento systém může upřednostňovat finanční zisky na úkor obchodní etiky, bezpečnosti či spravedlnosti.

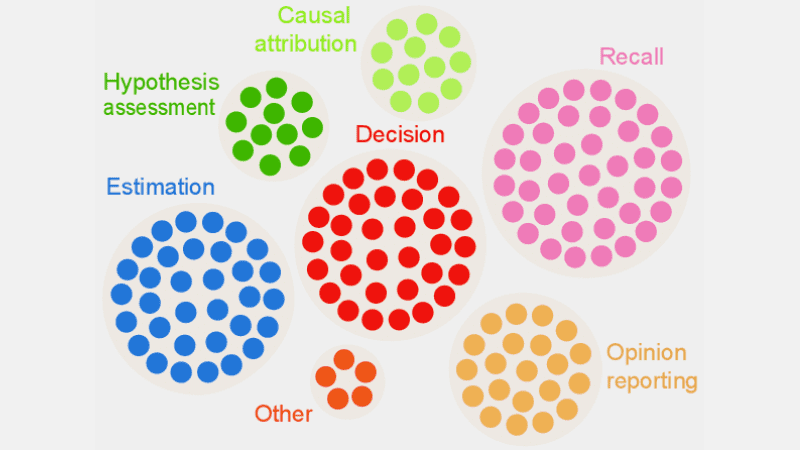

#4. Předpojatost hodnocení

Zkreslení hodnocení nastává, když jsou faktory nebo kritéria pro vyhodnocování výkonu systému umělé inteligence zkreslená.

Zdroj: Přehledná recenze

Příklad: Pokud systém umělé inteligence pro hodnocení výkonu používá standardní testy, které preferují určitou skupinu zaměstnanců, může to podporovat nerovnost.

#5. Zkreslení hlášení

Zkreslení hlášení nastává, když trénovací datová sada postrádá přesný odraz reality v četnosti událostí.

Příklad: Pokud bezpečnostní nástroj umělé inteligence nefunguje optimálně v určité kategorii, může ji označit jako podezřelou. Je to proto, že data, na kterých byl systém trénován, identifikovala historické incidenty spojené s touto kategorií jako nezabezpečené kvůli jejich vyšší frekvenci.

#6. Předpojatost výběru

Zkreslení výběru se objevuje, když jsou trénovací data vybrána bez náležité randomizace, nebo nereprezentují celou populaci.

Příklad: Je-li nástroj pro rozpoznávání obličeje trénován na omezených datech, může začít vykazovat diskriminaci vůči datům, se kterými se setkává méně často, například při identifikaci žen jiné barvy pleti v politice v porovnání s muži a jedinci se světlejší pletí.

#7. Implicitní zkreslení

Implicitní zkreslení se vyskytuje, když algoritmus umělé inteligence vytváří předpoklady na základě určitých osobních zkušeností, které nemusejí platit pro širší skupiny lidí.

Příklad: Pokud se datový vědec, který navrhuje algoritmus umělé inteligence, domnívá, že ženy preferují růžovou barvu před modrou nebo černou, může systém doporučovat produkty podle této představy, což neodpovídá preferencím všech žen. Mnoho žen má v oblibě modrou nebo černou barvu.

#8. Zkreslení skupinové atribuce

K tomuto zkreslení dochází, když tvůrci algoritmů aplikují vlastnosti, které jsou typické pro určité jedince, na celou skupinu. Zkreslení skupinové atribuce se často objevuje při náboru zaměstnanců.

Příklad: Nástroj pro nábor může zvýhodňovat uchazeče z konkrétní školy a diskriminovat ostatní studenty, kteří do této školy nepatří.

#9. Historická zaujatost

Sběr historických datových sad má zásadní význam při trénování algoritmů strojového učení. Pokud však nedáváte pozor, může ve vašich algoritmech dojít ke zkreslení v důsledku předsudků přítomných v těchto historických datech.

Příklad: Trénujete-li model umělé inteligence pomocí desetiletých historických údajů pro výběr kandidátů na technické pozice, může to upřednostňovat mužské uchazeče, pokud v trénovacích datech převažovali muži nad ženami.

#10. Zkreslení označování

Při trénování algoritmů strojového učení je často nutné označit velký objem dat. Proces označování dat se však může značně lišit, což může vést k nesrovnalostem a zkreslení v systému umělé inteligence.

Příklad: Trénujete-li algoritmus AI označováním koček na obrázcích pomocí rámečků, může algoritmus selhat při identifikaci kočky, pokud není vidět její obličej, zatímco dokáže identifikovat kočky s viditelným obličejem. Algoritmus je pak zaujatý vůči obrázkům koček, které jsou vyobrazeny čelně, a nedokáže je identifikovat z jiných úhlů.

#11. Zaujatost vyloučení

Zdroj: ResearchGate

Zaujatost vyloučení vzniká, když je během sběru dat neúmyslně nebo záměrně vyloučena konkrétní osoba, skupina lidí nebo kategorie, která je považována za irelevantní. K tomu často dochází během fáze přípravy dat v rámci životního cyklu strojového učení, kdy probíhá čištění dat a jejich příprava pro další použití.

Příklad: Představme si predikční systém, který má na základě nákupní aktivity během zimy určit oblíbenost konkrétního produktu. Pokud datový vědec odstraní říjnové nákupy s přesvědčením, že jsou chybné, a ponechá data pouze od listopadu do ledna, systém bude zaujatý vůči oblastem, kde zima trvá déle než tyto standardní měsíce.

Jak se do algoritmů dostávají předsudky?

Trénovací data

Hlavním zdrojem algoritmického zkreslení jsou zkreslená data používaná pro trénování algoritmů umělé inteligence a strojového učení. Pokud samotná trénovací data obsahují nerovnosti a předsudky, algoritmus se je naučí a zachová je.

Návrh

Při navrhování algoritmu může vývojář vědomě nebo nevědomě vnést do systému umělé inteligence své vlastní preference, které pak vedou ke zkreslení vůči určitým kategoriím.

Rozhodování

Datoví vědci a lídři se často rozhodují na základě svých osobních zkušeností, prostředí, přesvědčení. Tato rozhodnutí se promítají do algoritmů, což vede ke zkreslení.

Nedostatek diverzity

Nedostatečná diverzita ve vývojovém týmu může vést k tomu, že vznikají algoritmy, které nereprezentují celou populaci. Týmy nemají zkušenosti s jinými kulturami, prostředími a přesvědčeními, proto mohou jejich algoritmy vykazovat zkreslení.

Předzpracování dat

Metody používané k čištění a zpracování dat mohou zavádět algoritmické zkreslení. Pokud nejsou tyto metody pečlivě navrženy s ohledem na prevenci zkreslení, může to mít vážný dopad na model umělé inteligence.

Architektura

Architektura modelu a typ algoritmu strojového učení, který si vyberete, také mohou přispět ke zkreslení. Některé algoritmy jsou náchylnější ke zkreslení než jiné, a to v závislosti na tom, jak jsou navrženy.

Výběr funkcí

Výběr funkcí pro trénování algoritmu umělé inteligence je jedním ze zdrojů zkreslení. Pokud při výběru funkcí nebereme v úvahu jejich vliv na spravedlnost výstupu, může dojít ke zkreslení, které upřednostňuje určité kategorie.

Historie a kultura

Pokud je algoritmus trénován na datech z historie nebo specifických kultur, může zdědit předsudky, přesvědčení a normy. Tyto předsudky mohou ovlivnit výsledky umělé inteligence, i když jsou nespravedlivé a v současnosti irelevantní.

Datový drift

Data, která se používají pro trénování algoritmů umělé inteligence, se mohou v budoucnu stát irelevantní nebo zastaralé vlivem měnících se technologií nebo společnosti. Tyto datové soubory mohou obsahovat zkreslení a snižovat výkonnost.

Zpětnovazební smyčky

Některé systémy umělé inteligence mohou interagovat s uživateli a přizpůsobovat se jejich chování. Tímto způsobem může algoritmus posílit existující zkreslení. Pokud do systému vstoupí osobní předsudky uživatelů, může to generovat zkreslenou zpětnou vazbu.

Jak zjistit algoritmické zkreslení?

Definujte, co je „spravedlivé“

Pro odhalení nespravedlivých výsledků nebo zkreslení v algoritmech je nutné definovat, co přesně znamená „spravedlivé“ pro daný systém umělé inteligence. Můžeme zvážit faktory jako pohlaví, věk, rasa, sexualita, region nebo kultura.

Stanovte metriky pro výpočet spravedlnosti, jako jsou rovné příležitosti, prediktivní parita a dopady. Jakmile je definována „spravedlnost“, bude snazší odhalit to, co spravedlivé není, a situaci napravit.

Audit trénovacích dat

Důkladně analyzujte trénovací data a hledejte nerovnováhy a nekonzistence v reprezentaci různých skupin. Zkoumejte distribuci funkcí a ověřte, zda reprezentují demografické údaje ze skutečného světa či nikoliv.

K vizualizaci dat lze použít histogramy, heatmapy nebo bodové grafy, které mohou odhalit rozdíly a vzory, které statistická analýza sama o sobě neodhalí.

Kromě interních auditů zapojte externí odborníky k posouzení zkreslení v systému.

Měření výkonu modelu

Pro odhalení předsudků měřte výkon modelu umělé inteligence pro různé demografické skupiny. Trénink rozdělte do skupin podle rasy nebo pohlaví. Pro výpočet rozdílů ve výsledcích lze využít i metriky spravedlnosti.

Používejte vhodné algoritmy

Vybírejte algoritmy, které podporují spravedlivé výsledky a dokáží řešit zkreslení při trénování modelu. Algoritmy, které zohledňují spravedlnost, mají za cíl předcházet zkreslení a zároveň zajistit stejné předpovědi v různých skupinách.

Software pro detekci zkreslení

K odhalování zkreslení můžete použít specializované nástroje a knihovny. Tyto nástroje nabízejí metriky spravedlnosti, vizualizace, statistické testy a další prostředky pro odhalování zkreslení. Mezi populární nástroje patří AI Fairness 360 a IBM Fairness 360.

Vyžádejte si zpětnou vazbu od uživatelů

Zeptejte se uživatelů a zákazníků na jejich zpětnou vazbu k systému umělé inteligence. Povzbuďte je, aby sdíleli své upřímné názory, pokud se setkali s nespravedlivým zacházením. Tato data mohou pomoci odhalit problémy, které automatické nástroje nemusí zaznamenat.

Jak minimalizovat zkreslení v algoritmech

Diverzifikujte svou společnost

Vytvoření diverzity ve vaší společnosti a vývojovém týmu umožňuje rychlejší detekci a odstranění zkreslení. Je to proto, že zkreslení mohou rychleji rozpoznat uživatelé, které se ho dotýká.

Diverzifikujte svou společnost nejen z hlediska demografie, ale také dovedností a odbornosti. Zahrňte lidi různého pohlaví, identity, rasy, barvy pleti a ekonomického původu, stejně jako lidi s různými zkušenostmi a vzděláním.

Získáte tak různé pohledy, zkušenosti, kulturní hodnoty, preference, a to vám pomůže zlepšit spravedlnost vašich algoritmů a snížit předsudky.

Podporujte transparentnost

Buďte se svým týmem transparentní ohledně cílů, algoritmů, zdrojů dat a rozhodnutí týkajících se systému umělé inteligence. To uživatelům pomůže pochopit, jak systém funguje a proč generuje určité výsledky. Tato transparentnost podpoří důvěru.

Algoritmy zohledňující spravedlnost

Při vývoji modelu používejte algoritmy, které berou v úvahu spravedlnost. Získáte tak spravedlivé výsledky pro různé skupiny. Důležité je to zejména u systémů umělé inteligence pro regulované oblasti jako finance a zdravotnictví.

Vyhodnoťte výkon modelu

Otestujte modely a prozkoumejte výkonnost umělé inteligence v různých skupinách. Získáte tak přehled o problémech, které nejsou viditelné v souhrnných metrikách. Simulujte různé scénáře a ověřte výkon v těchto situacích, včetně komplexních.

Dodržujte etické pokyny

Formulujte etické pokyny pro vývoj systémů umělé inteligence, které berou v úvahu spravedlnost, soukromí, bezpečnost a lidská práva. Tyto zásady je třeba prosazovat v celé organizaci, aby se férovost zvýšila v celé organizaci a odrážela se ve výstupech systému umělé inteligence.

Stanovte kontroly a odpovědnosti

Stanovte jasné povinnosti pro každého, kdo pracuje na návrhu, vývoji, údržbě a nasazení systému umělé inteligence. Zaveďte kontroly pomocí přísných protokolů a rámců, abyste se vypořádali s předsudky, chybami a dalšími problémy.

Kromě toho provádějte pravidelné audity, abyste minimalizovali zkreslení a usilovali o neustálé zlepšování. Zůstaňte informováni o nedávných změnách v technologii, demografických údajích a dalších faktorech.

Příklady algoritmických zkreslení v reálném světě

#1. Algoritmus společnosti Amazon

Amazon je lídrem v e-commerce. Nicméně jeho náborový nástroj, který využíval umělou inteligenci k hodnocení kandidátů na základě jejich kvalifikace, vykazoval genderové zkreslení. Tento systém umělé inteligence byl trénován na základě životopisů předchozích uchazečů o technické pozice.

Bohužel, v těchto datech převažovali mužští žadatelé, což se umělá inteligence naučila. Proto začala neúmyslně upřednostňovat mužské žadatele v technických oborech před ženami, které byly nedostatečně zastoupeny. Amazon nakonec musel tento nástroj v roce 2017 ukončit.

#2. Rasistické americké zdravotnické algoritmy

Algoritmus, který nemocnice v USA využívaly k předpovídání pacientů vyžadujících další péči, byl zaujatý vůči bílým pacientům. Systém hodnotil lékařské potřeby pacientů na základě jejich historických výdajů za zdravotní péči a koreloval náklady se zdravotními potřebami.

Algoritmus systému nebral v potaz rozdíly v úhradách zdravotní péče mezi bílými a černými pacienty. Černí pacienti často platili za urgentní případy, i když měli neléčené nemoci. Byli proto zařazováni do kategorie zdravějších pacientů a neměli nárok na další péči ve srovnání s bílými pacienty.

#3. Diskriminační algoritmus společnosti Google

Bylo zjištěno, že online reklamní systém společnosti Google diskriminuje. Ukázalo se, že reklamy s nabídkou vysoce placených pozic, například pro generální ředitele, se zobrazují mnohem častěji mužům než ženám. I když 27 % amerických generálních ředitelů tvoří ženy, v Google se zobrazovaly méně, přibližně v 11 % případů.

Algoritmus mohl dosáhnout tohoto výsledku tím, že se naučil chování uživatelů a preferoval zobrazování reklam pro vysoce placené pozice mužům, protože častěji klikali na tyto reklamy.

Závěr

Algoritmické zkreslení v systémech strojového učení a umělé inteligence může vést k nespravedlivým výsledkům. Tyto výsledky mohou ovlivnit jednotlivce v mnoha oblastech, od zdravotnictví, kybernetické bezpečnosti a e-commerce, až po volby, zaměstnání. Může vést k diskriminaci na základě pohlaví, rasy, demografie nebo sexuální orientace.

Proto je důležité omezovat zkreslení v algoritmech AI a ML. Informace uvedené výše pomohou odhalovat předsudky a minimalizovat je, což umožní vytvářet spravedlivé systémy umělé inteligence pro uživatele.

Můžete si také přečíst o správě umělé inteligence.