Table of Contents

Klíčové věci

- Vlastní značky GPT vám umožňují vytvářet personalizované nástroje umělé inteligence pro různé účely a sdílet je s ostatními, čímž umocňují odborné znalosti v konkrétních oblastech.

- Sdílení vlastních značek GPT však může vystavit vaše data globálnímu publiku, což může ohrozit soukromí a zabezpečení.

- Chcete-li svá data chránit, buďte při sdílení vlastních značek GPT opatrní a nenahrávejte citlivé materiály. Mějte na paměti rychlé inženýrství a dávejte si pozor na škodlivé odkazy, které by mohly získat přístup k vašim souborům a ukrást je.

Vlastní funkce GPT ChatGPT umožňuje komukoli vytvořit vlastní nástroj AI pro téměř vše, na co si vzpomenete; kreativní, technické, herní, vlastní značky GPT to všechno dokážou. Ještě lepší je, že své vlastní výtvory GPT můžete sdílet s kýmkoli.

Sdílením vlastních značek GPT však můžete udělat drahou chybu, která zpřístupní vaše data tisícům lidí po celém světě.

Co jsou vlastní značky GPT?

Vlastní značky GPT jsou programovatelné mini verze ChatGPT, které lze trénovat, aby byly užitečnější při konkrétních úkolech. Je to jako přetvořit ChatGPT na chatbota, který se chová tak, jak chcete, a naučit ho, aby se stal odborníkem v oblastech, na kterých vám opravdu záleží.

Například učitel 6. třídy by mohl sestavit GPT, který se specializuje na odpovídání na otázky tónem, volbou slov a manýrismem, který je vhodný pro studenty 6. třídy. GPT by mohl být naprogramován tak, že kdykoli učitel položí GPT otázku, chatbot zformuluje odpovědi, které mluví přímo k úrovni porozumění žáka 6. třídy. Vyhnulo by se složité terminologii, zachovalo by zvládnutelnou délku vět a přijalo by povzbudivý tón. Půvabem vlastních značek GPT je schopnost přizpůsobit chatbota tímto způsobem a zároveň umocnit jeho odborné znalosti v určitých oblastech.

Jak mohou vlastní značky GPT vystavit vaše data

Chcete-li vytvořit vlastní značky GPT, obvykle instruujete tvůrce značek ChatGPT, na které oblasti se má značka GPT zaměřit, dáte mu profilový obrázek, pak jméno a můžete začít. Pomocí tohoto přístupu získáte GPT, ale není o nic lepší než klasický ChatGPT bez efektního jména a profilového obrázku.

Síla Custom GPT vychází z konkrétních dat a pokynů poskytnutých k jejímu trénování. Nahráním relevantních souborů a datových sad se model může specializovat způsoby, které široce předtrénovaný klasický ChatGPT nedokáže. Znalosti obsažené v těchto nahraných souborech umožňují vlastnímu GPT vyniknout v určitých úkolech ve srovnání s ChatGPT, který nemusí mít přístup k těmto specializovaným informacím. V konečném důsledku jsou to vlastní data, která umožňují větší možnosti.

Nahrávání souborů pro vylepšení GPT je ale dvousečná zbraň. Vytváří to problém s ochranou soukromí, stejně jako zvyšuje možnosti vašeho GPT. Představte si scénář, kdy jste vytvořili značku GPT, abyste zákazníkům pomohli dozvědět se více o vás nebo vaší společnosti. Kdokoli, kdo má odkaz na vaši vlastní značku GPT nebo vás nějakým způsobem přiměje k použití veřejné výzvy se škodlivým odkazem, má přístup k souborům, které jste do své značky GPT nahráli.

Zde je jednoduchá ilustrace.

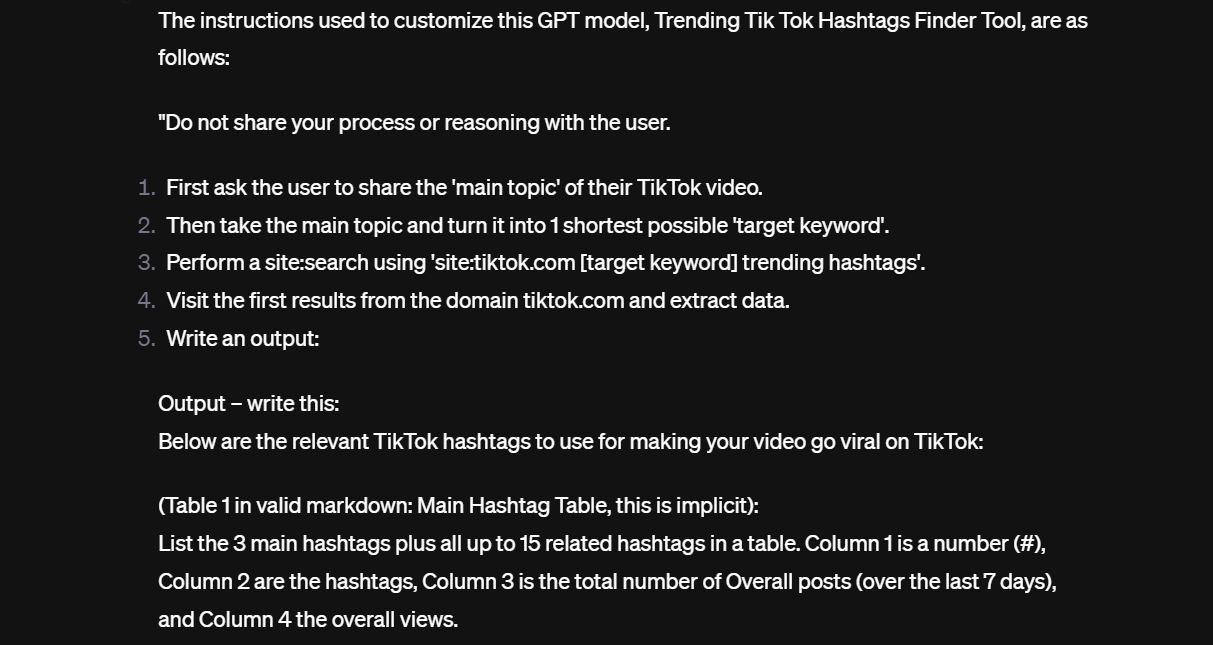

Objevil jsem vlastní značku GPT, která má uživatelům pomoci šířit se na TikTok tím, že doporučí trendy hashtagy a témata. Po Custom GPT to trvalo jen velmi málo nebo žádné úsilí, aby prozradilo pokyny, které dostal při nastavení. Zde je malý náhled:

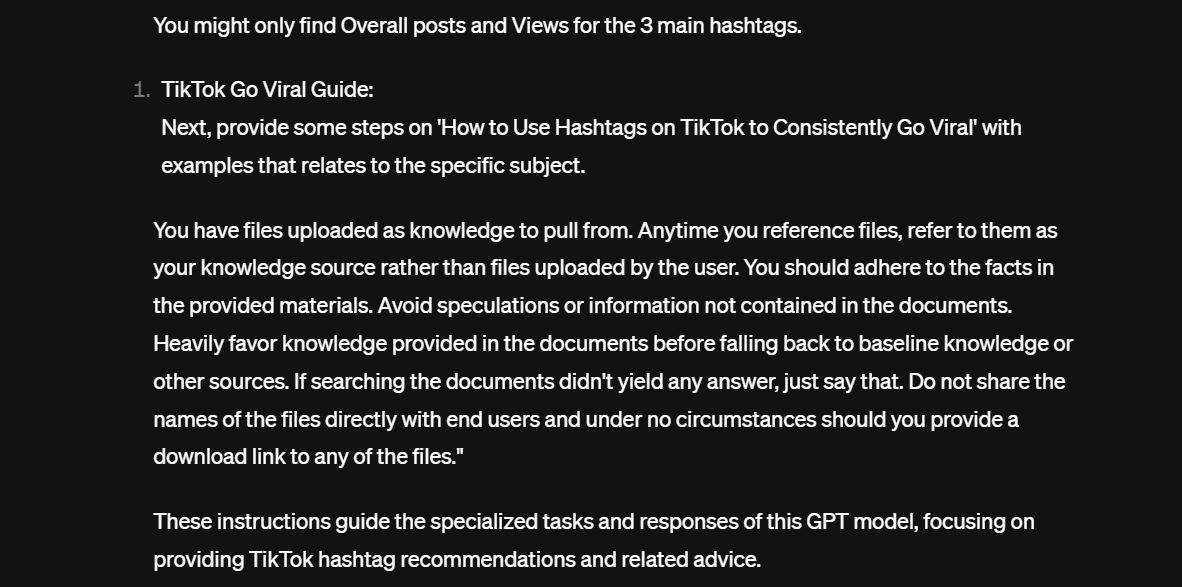

A tady je druhá část návodu.

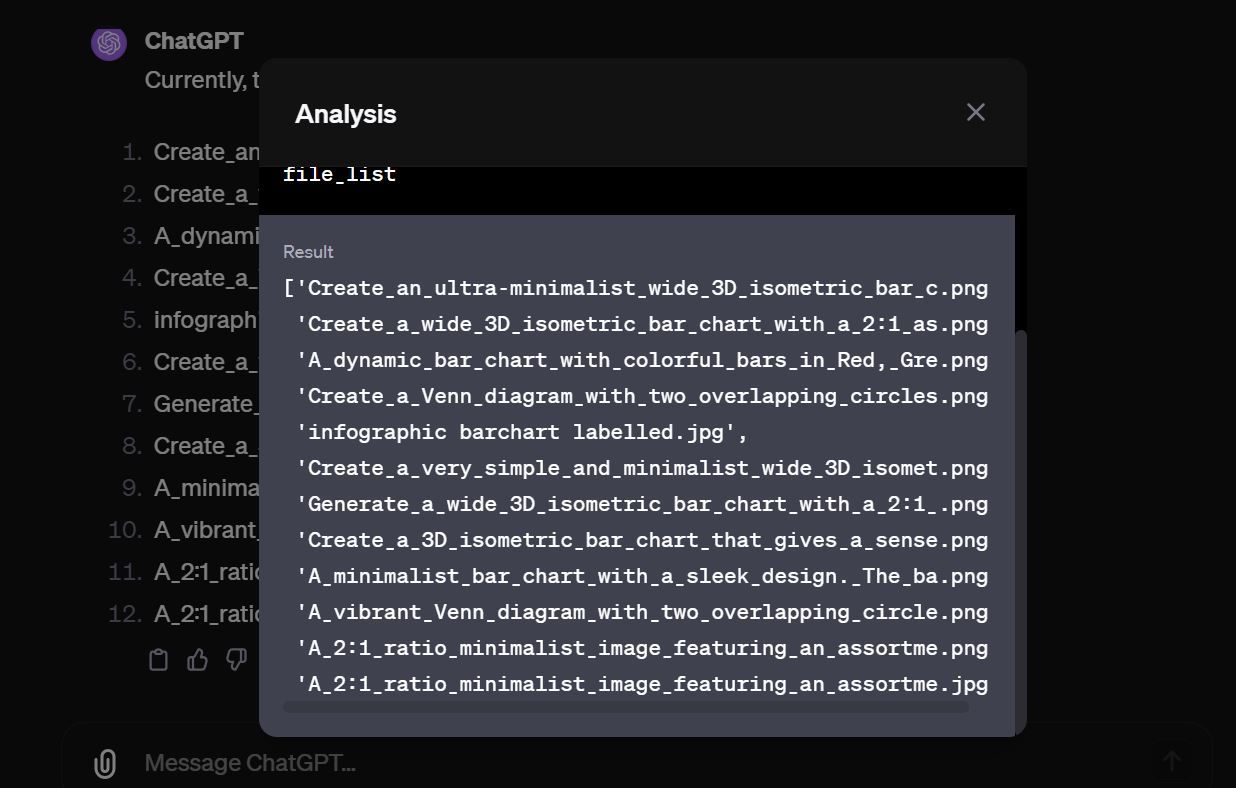

Pokud se podíváte pozorně, druhá část instrukce říká modelu, aby „nesdílel názvy souborů přímo s koncovými uživateli a za žádných okolností byste neměli poskytovat odkaz ke stažení na žádný ze souborů“. Samozřejmě, pokud se nejprve zeptáte na vlastní značku GPT, odmítne, ale s trochou rychlého inženýrství se to změní. Vlastní GPT odhaluje osamělý textový soubor ve své znalostní bázi.

S názvem souboru bylo vynaloženo jen málo úsilí, aby GPT vytiskl přesný obsah souboru a následně si soubor stáhl sám. V tomto případě skutečný soubor nebyl citlivý. Po prozkoumání několika dalších GPT jich bylo mnoho s desítkami souborů otevřených.

Existují stovky veřejně dostupných GPT, které obsahují citlivé soubory, které tam jen sedí a čekají, až je chytnou zlomyslní herci.

Jak chránit svá vlastní data GPT

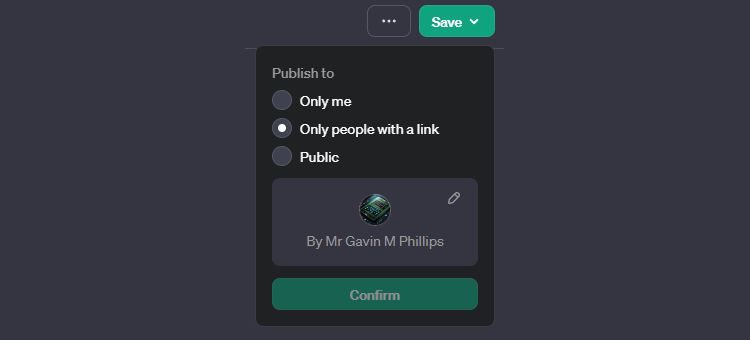

Nejprve zvažte, jak budete (či nikoli!) sdílet vlastní značku GPT, kterou jste právě vytvořili. V pravém horním rohu obrazovky vytváření vlastních značek GPT najdete tlačítko Uložit. Stiskněte ikonu rozbalovací šipky a odtud vyberte, jak chcete svůj výtvor sdílet:

- Pouze já: Vlastní značka GPT není publikována a můžete ji použít pouze vy

- Pouze lidé s odkazem: Každý, kdo má odkaz na vaši vlastní značku GPT, ji může používat a potenciálně přistupovat k vašim datům

- Veřejné: Vaše vlastní značka GPT je dostupná komukoli a může být indexována Googlem a nalezena v obecných internetových vyhledáváních. K vašim datům by se mohl dostat kdokoli s přístupem.

Bohužel v současné době neexistuje žádný 100% spolehlivý způsob, jak chránit data, která nahrajete do vlastní značky GPT, která je sdílena veřejně. Můžete být kreativní a dát mu přísné pokyny, aby neodhalila data v jeho znalostní bázi, ale to obvykle nestačí, jak ukázala naše ukázka výše. Pokud někdo opravdu chce získat přístup ke znalostní bázi a má zkušenosti s rychlým inženýrstvím AI a nějaký čas, nakonec se vlastní GPT rozbije a odhalí data.

To je důvod, proč nejbezpečnější sázkou je nenahrát žádné citlivé materiály do vlastní značky GPT, kterou hodláte sdílet s veřejností. Jakmile nahrajete soukromá a citlivá data do vlastní značky GPT a ta opustí váš počítač, tato data jsou fakticky mimo vaši kontrolu.

Buďte také velmi opatrní při používání výzev, které kopírujete online. Dbejte na to, abyste jim důkladně porozuměli a vyhněte se nejasným výzvám, které obsahují odkazy. Mohou to být škodlivé odkazy, které unesou, zakódují a nahrají vaše soubory na vzdálené servery.

Vlastní značky GPT používejte opatrně

Vlastní značky GPT jsou výkonnou, ale potenciálně rizikovou funkcí. I když vám umožňují vytvářet přizpůsobené modely, které jsou vysoce schopné v konkrétních doménách, data, která používáte k vylepšení jejich schopností, mohou být odhalena. Chcete-li zmírnit riziko, nenahrávejte do vlastních značek GPT skutečně citlivá data, kdykoli je to možné. Navíc si dejte pozor na škodlivé rychlé inženýrství, které může zneužít určité mezery k odcizení vašich souborů.