Hledáte nástroje pro zlepšení vašeho SEO hodnocení, expozice a konverzí? K tomu potřebujete nástroj pro procházení webu. Webový prohledávač je počítačový program, který prohledává internet. Webové pavouci, software pro extrakci webových dat a programy pro škrábání webových stránek jsou příklady technologií procházení webu na internetu. Je také známý jako pavoučí bot nebo pavouk. Dnes se podíváme na některé bezplatné nástroje pro procházení webu ke stažení.

Table of Contents

25 nejlepších bezplatných nástrojů pro procházení webu

Nástroje pro procházení webu poskytují velké množství informací pro dolování a analýzu dat. Jeho primárním účelem je indexování webových stránek na internetu. Dokáže detekovat nefunkční odkazy, duplicitní obsah a chybějící názvy stránek a identifikovat vážné problémy se SEO. Seškrabávání online dat může být pro vaši firmu přínosem v mnoha ohledech.

- Několik aplikací webového prohledávače může správně procházet data z libovolné adresy URL webových stránek.

- Tyto programy vám pomohou zlepšit strukturu vašich webových stránek tak, aby jim vyhledávače porozuměly a zvýšily vaše hodnocení.

V seznamu našich nejlepších nástrojů jsme sestavili seznam bezplatných stažení webových prohledávačů a jejich funkcí a nákladů, ze kterých si můžete vybrat. Seznam obsahuje také placené aplikace.

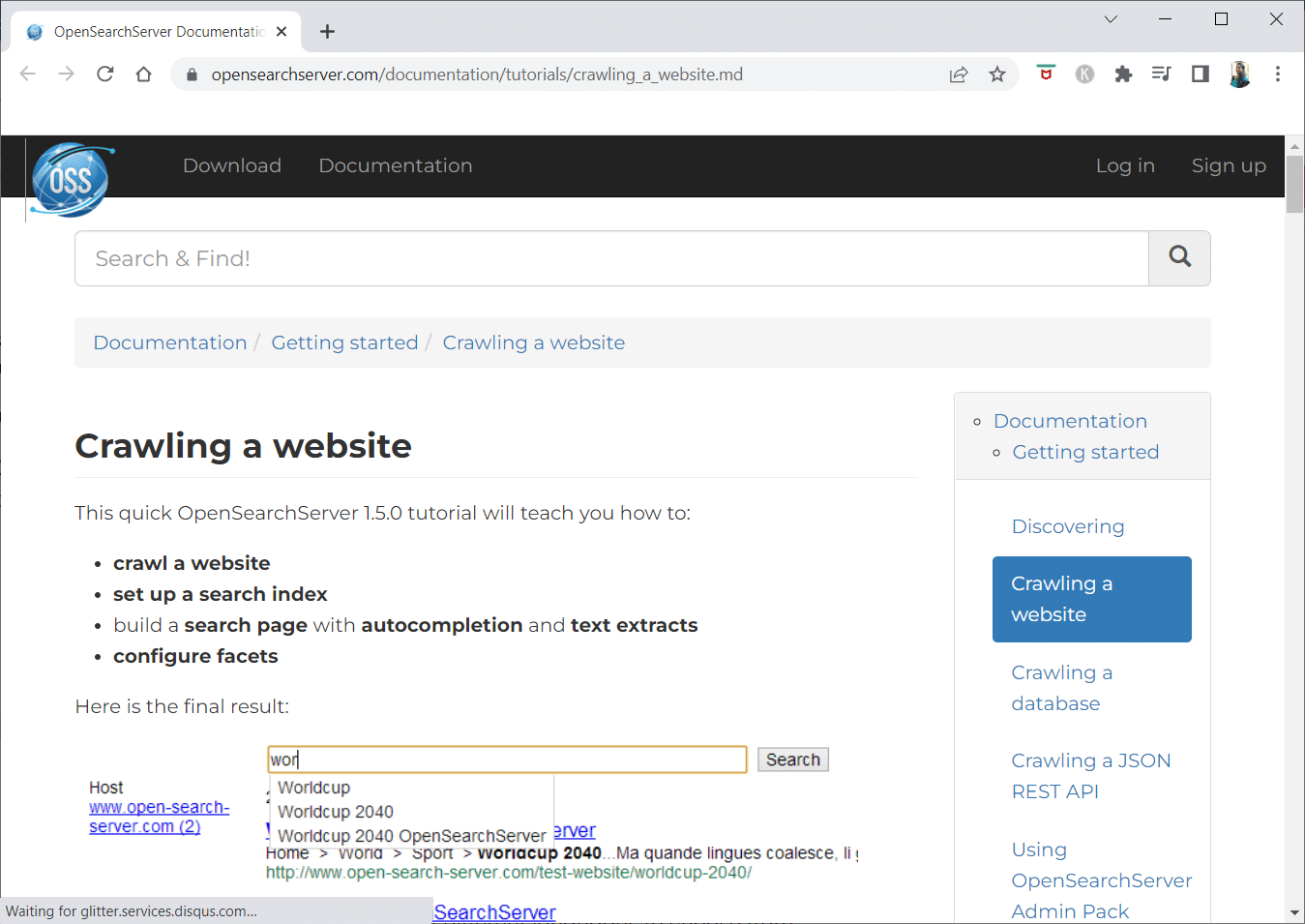

1. Otevřete vyhledávací server

OpenSearchServer je bezplatný webový prohledávač a má jedno z nejlepších hodnocení na internetu. Jedna z nejlepších dostupných alternativ.

- Jedná se o zcela integrované řešení.

- Open Search Server je procházení webu a vyhledávač, který je bezplatný a má otevřený zdroj.

- Je to jednorázové a nákladově efektivní řešení.

- Dodává se s komplexní sadou vyhledávacích schopností a možností vytvořit si vlastní strategii indexování.

- Prohledávače mohou indexovat téměř cokoliv.

- Na výběr je fulltextové, booleovské a fonetické vyhledávání.

- Můžete si vybrat ze 17 různých jazyků.

- Provádějí se automatické klasifikace.

- Můžete si vytvořit časový rozvrh pro věci, které se stávají často.

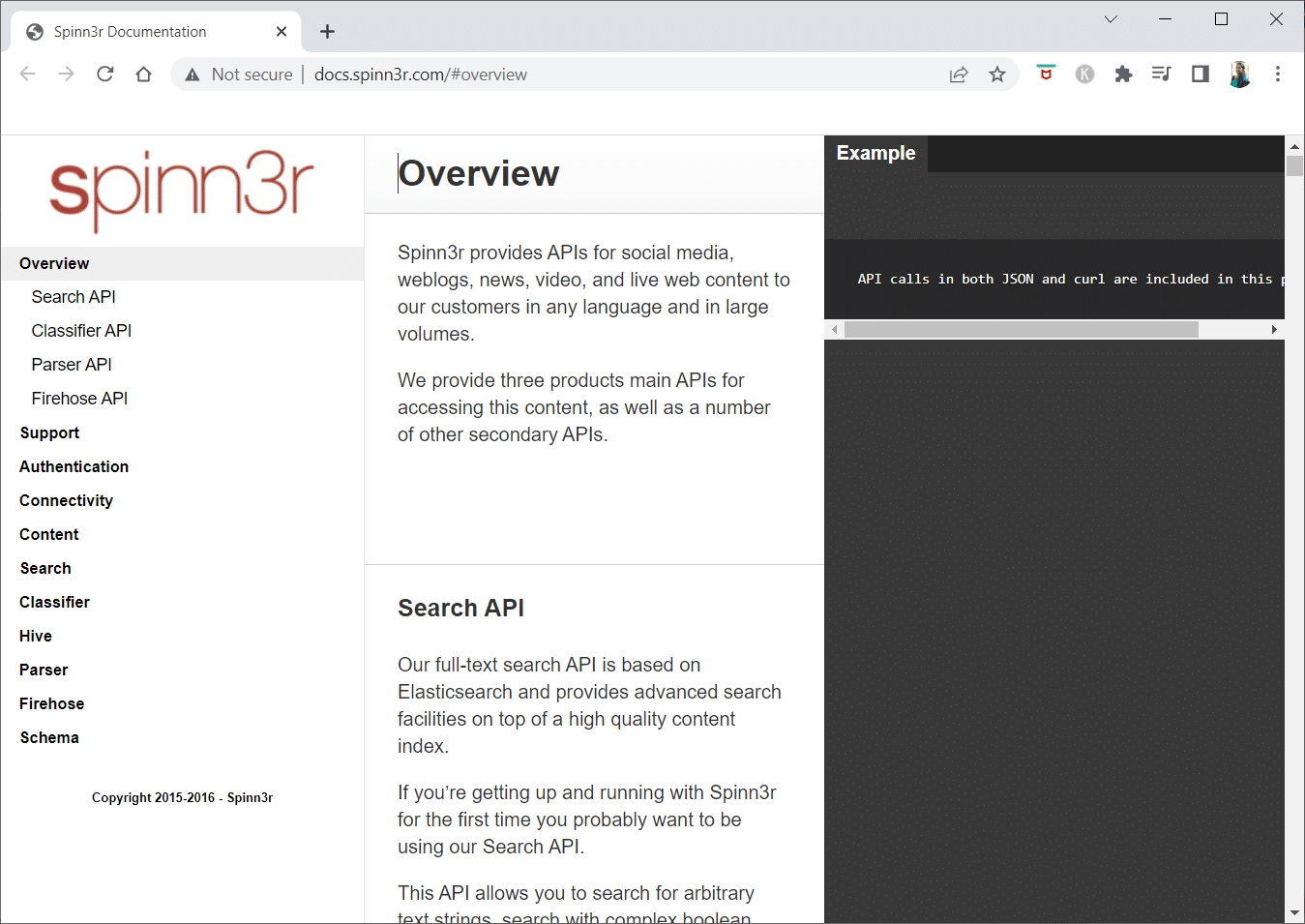

2. Spinn3r

Webový prohledávací program Spinn3r vám umožňuje plně extrahovat obsah z blogů, zpráv, stránek sociálních sítí, kanálů RSS a kanálů ATOM.

- Dodává se s bleskově rychlým API, které zvládne 95 % práce s indexováním.

- Tato aplikace pro procházení webu obsahuje pokročilou ochranu proti spamu, která odstraňuje spam a nevhodné jazykové použití a zlepšuje zabezpečení dat.

- Webová škrabka neustále hledá na webu aktualizace z mnoha zdrojů, aby vám mohla nabídnout obsah v reálném čase.

- Indexuje obsah stejným způsobem jako Google a extrahovaná data se ukládají jako soubory JSON.

- Parser API vám umožňuje rychle analyzovat a spravovat informace pro libovolné webové adresy URL.

- Firehose API je navrženo pro hromadný přístup k enormním objemům dat.

-

Jednoduché HTTP hlavičky se používají k ověření všech API Spinn3r.

- Toto je nástroj pro procházení webu zdarma ke stažení.

- Rozhraní Classifier API umožňuje vývojářům přenášet text (nebo adresy URL), které mají být označeny naší technologií strojového učení.

3. Import.io

Import.io vám umožňuje seškrábat miliony webových stránek během několika minut a vytvořit 1000+ API na základě vašich potřeb, aniž byste museli psát jediný řádek kódu.

- Nyní jej lze ovládat programově a data lze nyní načítat automaticky.

- Extrahujte data z mnoha stránek jediným stisknutím tlačítka.

- Dokáže automaticky rozpoznat stránkované seznamy nebo můžete kliknout na další stránku.

- Online data můžete začlenit do své aplikace nebo webu pouze několika kliknutími.

- Vytvořte všechny potřebné adresy URL během několika sekund pomocí vzorů, jako jsou čísla stránek a názvy kategorií.

- Import.io zjednodušuje demonstraci, jak vytáhnout data ze stránky. Jednoduše vyberte sloupec z datové sady a ukažte na něco na stránce, co vás zaujme.

- Na jejich webových stránkách můžete obdržet nabídku.

- Odkazy na stránkách seznamu vedou na podrobné stránky s dalšími informacemi.

- Můžete se k nim připojit pomocí Import.io a získat všechna data ze stránek s podrobnostmi najednou.

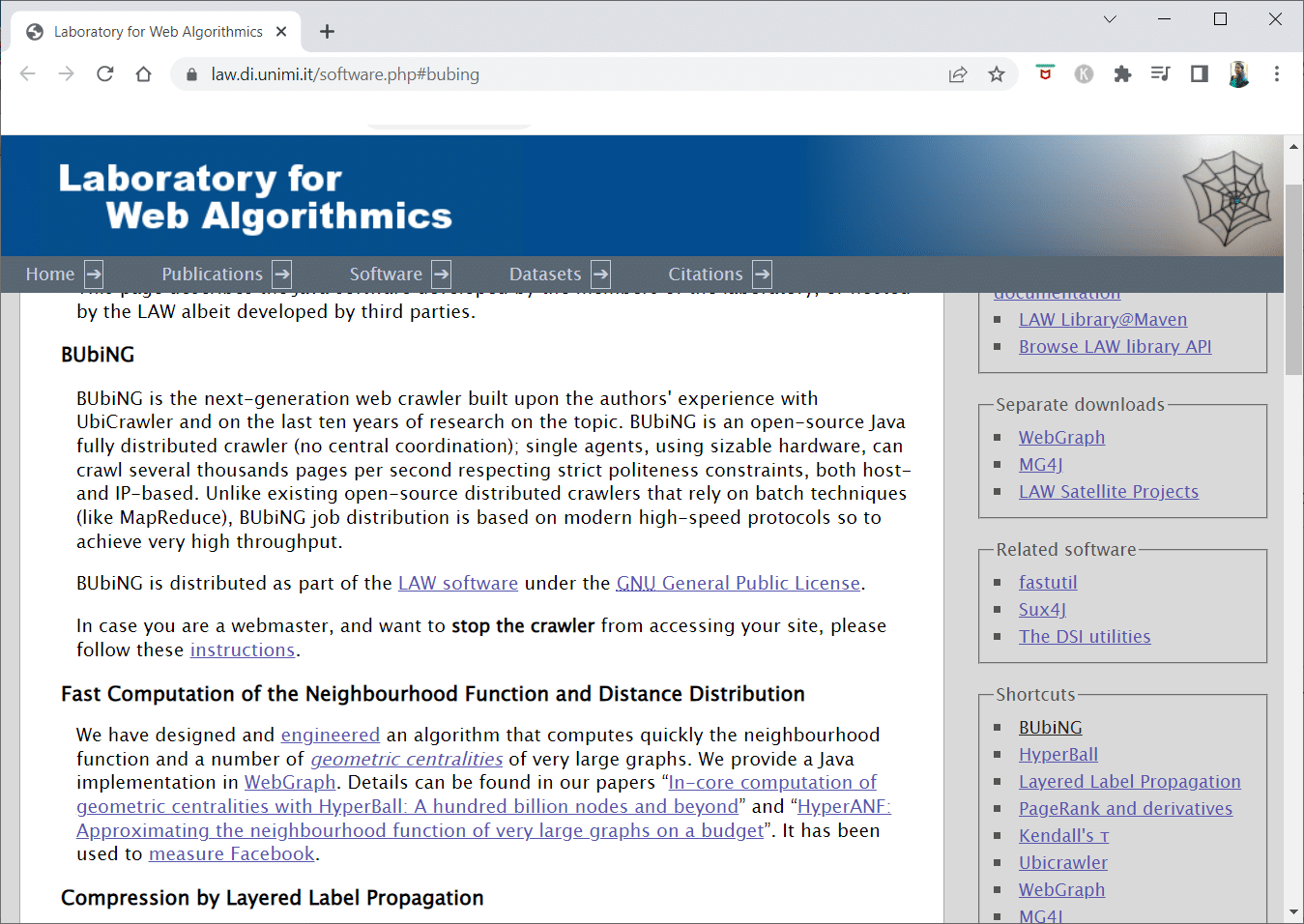

4. BUBING

BUbiNG, nástroj pro procházení webu nové generace, je vyvrcholením zkušeností autorů s UbiCrawler a deseti let výzkumu tohoto tématu.

- Jediný agent může procházet tisíce stránek za sekundu při dodržení přísných standardů zdvořilosti, a to jak na základě hostitele, tak na základě IP.

- Jeho distribuce úloh je postavena na současných vysokorychlostních protokolech, které poskytují velmi vysokou propustnost, na rozdíl od dřívějších open source distribuovaných prohledávačů, které závisí na dávkových technikách.

- K detekci téměř duplikátů používá otisk odstraněné stránky.

- BUbiNG je kompletně distribuovaný open-source Java crawler.

- Má to spoustu paralel.

- Existuje mnoho lidí, kteří tento produkt využívají.

- Je to rychlé.

- Umožňuje rozsáhlé procházení.

5. GNU Wget

GNU Wget je bezplatný nástroj pro procházení webu, který je k dispozici ke stažení zdarma, a je to softwarový program s otevřeným zdrojovým kódem napsaný v C, který vám umožňuje získávat soubory přes HTTP, HTTPS, FTP a FTPS.

- Jedním z nejvýraznějších aspektů této aplikace je schopnost vytvářet soubory zpráv založené na NLS v různých jazycích.

- Stahování, které bylo zastaveno, můžete restartovat pomocí REST a RANGE.

- V případě potřeby může také transformovat absolutní odkazy ve stažených dokumentech na relativní odkazy.

- Rekurzivně používejte zástupné znaky v názvech souborů a zrcadlených adresářích.

- Soubory zpráv založené na NLS pro různé jazyky.

- Při zrcadlení se vyhodnocují časová razítka místních souborů, aby se určilo, zda je třeba dokumenty znovu stáhnout.

6. Webhose.io

Webhose.io je fantastická aplikace pro procházení webu, která vám umožňuje skenovat data a extrahovat klíčová slova v několika jazycích pomocí různých filtrů, které pokrývají širokou škálu zdrojů.

- Archiv také umožňuje uživatelům prohlížet předchozí data.

- Kromě toho jsou objevy procházení dat webhose.io dostupné až v 80 jazycích.

- Všechny osobně identifikovatelné informace, které byly kompromitovány, lze nalézt na jednom místě.

- Prozkoumejte darknety a aplikace pro zasílání zpráv ohledně kybernetických hrozeb.

-

Formáty XML, JSON a RSS jsou také přístupné pro seškrabovaná data.

- Na jejich webových stránkách můžete obdržet nabídku.

- Uživatelé mohou jednoduše indexovat a vyhledávat strukturovaná data na Webhose.io.

- Ve všech jazycích může monitorovat a analyzovat mediální výstupy.

- Je možné sledovat diskuze na nástěnkách a fórech.

- Umožňuje vám sledovat klíčové blogové příspěvky z celého webu.

7. Norconex

Norconex je vynikajícím zdrojem pro firmy, které hledají open source aplikaci pro procházení webu.

- Tento plně vybavený kolektor lze použít nebo integrovat do vašeho programu.

- Může také obsahovat doporučený obrázek stránky.

- Norconex vám dává možnost procházet obsah libovolného webu.

- Je možné použít jakýkoli operační systém.

- Tento webový prohledávací software dokáže procházet miliony stránek na jediném serveru s průměrnou kapacitou.

- Obsahuje také sadu nástrojů pro úpravu obsahu a metadat.

- Získejte metadata pro dokumenty, na kterých právě pracujete.

-

Stránky vykreslené pomocí JavaScriptu jsou podporovány.

- Umožňuje detekci několika jazyků.

- Umožňuje pomoc s překladem.

- Rychlost, kterou se plazíte, se může změnit.

- Dokumenty, které byly změněny nebo odstraněny, jsou identifikovány.

- Toto je zcela bezplatný program pro procházení webu.

8. Dexi.io

Dexi.io je aplikace pro procházení webu založená na prohlížeči, která vám umožňuje získávat informace z libovolného webu.

-

Extraktory, prolézačky a trubky jsou tři typy robotů, které můžete použít k provedení operace škrábání.

- Vývoj trhu se předpovídá pomocí zpráv Delta.

- Vaše shromážděná data budou uchována po dobu dvou týdnů na serverech Dexi.io před archivací, nebo můžete extrahovaná data okamžitě exportovat jako soubory JSON nebo CSV.

- Na jejich webových stránkách můžete obdržet nabídku.

- Jsou nabízeny profesionální služby, jako je zajištění kvality a průběžná údržba.

- Nabízí komerční služby, které vám pomohou splnit vaše potřeby v oblasti dat v reálném čase.

- Je možné sledovat skladové zásoby a ceny pro neomezený počet SKU/produktů.

- Umožňuje vám integrovat data pomocí živých řídicích panelů a úplné analýzy produktů.

- Pomáhá vám připravit a vypláchnout webově organizovaná a připravená produktová data.

9. Zyte

Zyte je cloudový nástroj pro extrakci dat, který pomáhá desítkám tisíc vývojářů najít důležité informace. Je to také jedna z nejlepších bezplatných aplikací pro procházení webu.

- Uživatelé mohou škrábat webové stránky pomocí její open source vizuální škrabací aplikace, aniž by znali jakékoli kódování.

-

Crawlera, komplexní proxy rotátor používaný společností Zyte, umožňuje uživatelům snadno procházet velké weby nebo weby chráněné proti botům a přitom se vyhýbat protiopatřením botů.

- Vaše online informace jsou poskytovány podle plánu a konzistentně. Místo správy proxy se tedy můžete soustředit na získávání dat.

- Díky funkcím chytrého prohlížeče a vykreslování lze nyní snadno spravovat antiboty zacílené na vrstvu prohlížeče.

- Na jejich stránkách můžete získat cenovou nabídku.

- Uživatelé mohou procházet z mnoha IP adres a oblastí pomocí jednoduchého HTTP API, což eliminuje potřebu údržby proxy.

- Pomáhá vám generovat hotovost a zároveň šetří čas získáváním informací, které požadujete.

- Umožňuje extrahovat webová data ve velkém měřítku a zároveň šetřit čas na kódování a údržbu pavouka.

10. Apache Nutch

Apache Nutch je nepochybně na vrcholu seznamu pro největší open source webovou prohledávačskou aplikaci.

- Může pracovat na jednom stroji. Nejlépe však funguje na clusteru Hadoop.

- Pro autentizaci se používá protokol NTLM.

- Má distribuovaný systém souborů (přes Hadoop).

- Je to známý open-source projekt online pro extrakci dat, který je přizpůsobitelný a škálovatelný pro dolování dat.

- Používá jej mnoho datových analytiků, vědců, vývojářů aplikací a specialistů na dolování webových textů po celém světě.

- Jedná se o multiplatformní řešení založené na Javě.

- Ve výchozím nastavení se načítání a analýza provádí nezávisle.

- Data jsou mapována pomocí XPath a jmenných prostorů.

- Obsahuje databázi linkových grafů.

11. VisualScraper

VisualScraper je další fantastický nekódovací webový škrabák pro extrahování dat z internetu.

- Nabízí jednoduché uživatelské rozhraní typu point-and-click.

- Nabízí také online scrapingové služby, jako je šíření dat a vytváření softwarových extraktorů.

- Dohlíží i na vaše konkurenty.

- Uživatelé mohou pomocí Visual Scraper naplánovat spuštění svých projektů v určitou dobu nebo nechat sekvenci opakovat každou minutu, den, týden, měsíc a rok.

- Je to levnější a zároveň efektivnější.

- Není tam ani kód, který by se dal mluvit.

- Toto je zcela bezplatný program pro procházení webu.

- Data v reálném čase lze extrahovat z několika webových stránek a uložit jako soubory CSV, XML, JSON nebo SQL.

- Uživatelé jej mohou používat k pravidelnému získávání novinek, aktualizací a příspěvků na fóru.

- Údaje jsou 100% přesné a přizpůsobené.

12. WebSphinx

WebSphinx je fantastická osobní bezplatná aplikace pro procházení webu, která se snadno nastavuje a používá.

- Je určen pro pokročilé uživatele webu a programátory Java, kteří chtějí automaticky skenovat omezenou část internetu.

- Toto online řešení extrakce dat zahrnuje knihovnu tříd Java a interaktivní programovací prostředí.

- Stránky lze zřetězit a vytvořit tak jeden dokument, který lze procházet nebo tisknout.

-

Extrahujte veškerý text, který odpovídá danému vzoru, ze sekvence stránek.

- Díky tomuto balíčku mohou být webové prohledávače nyní napsány v Javě.

- Crawler Workbench a knihovna tříd WebSPHINX jsou součástí WebSphinx.

- Crawler Workbench je grafické uživatelské rozhraní, které vám umožňuje přizpůsobit a provozovat webový prohledávač.

- Ze skupiny webových stránek lze vytvořit graf.

- Uložte stránky na místní disk pro čtení offline.

13. OutWit Hub

Platforma OutWit Hub se skládá z jádra s rozsáhlou knihovnou funkcí pro rozpoznávání a extrakci dat, na kterých lze vytvářet nekonečné množství různých aplikací, z nichž každá využívá funkce jádra.

- Tato aplikace webového prohledávače může prohledávat stránky a uchovávat data, která objeví, přístupným způsobem.

- Je to víceúčelový sklízecí stroj s tolika funkcemi, kolik je možné, aby vyhovoval různým požadavkům.

- Hub existuje již dlouhou dobu.

- Vyvinula se v užitečnou a rozmanitou platformu pro netechnické uživatele a IT profesionály, kteří vědí, jak kódovat, ale uznávají, že PHP není vždy ideální volbou pro extrakci dat.

- OutWit Hub poskytuje jediné rozhraní pro seškrabování skromného nebo masivního množství dat v závislosti na vašich požadavcích.

- Umožňuje vám seškrábnout jakoukoli webovou stránku přímo z prohlížeče a vytvořit automatické agenty, kteří získají data a připraví je podle vašich požadavků.

- Na jejich webových stránkách můžete obdržet nabídku.

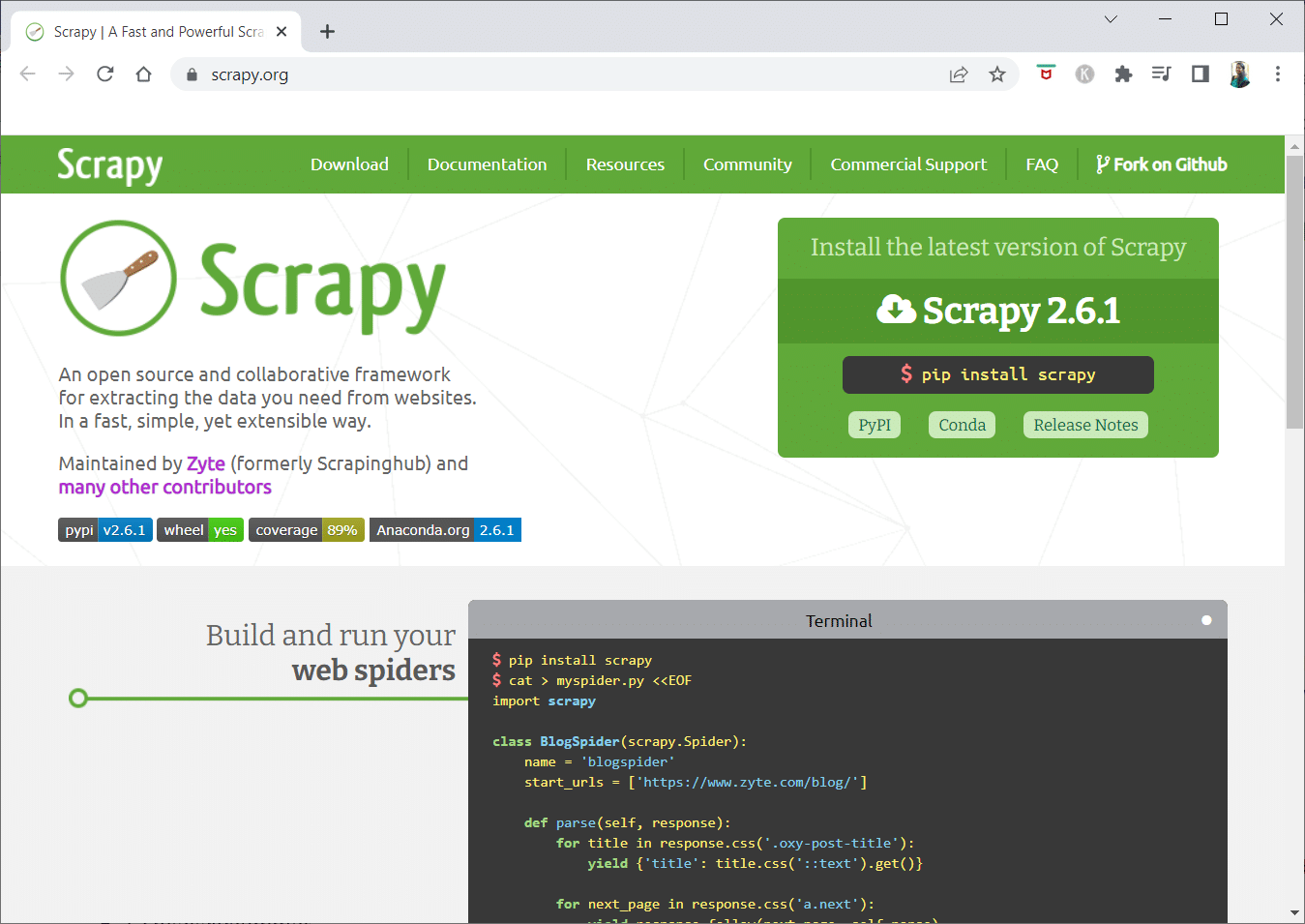

14. Odřený

Scrapy je online škrabací rámec Pythonu pro vytváření škálovatelných webových prohledávačů.

- Jedná se o kompletní rámec pro procházení webu, který zpracovává všechny vlastnosti, které ztěžují vytváření webových prohledávačů, jako je proxy middleware a dotazy na dotazy.

- Můžete napsat pravidla pro extrahování dat a poté nechat Scrapy, aby se postaral o zbytek.

- Je snadné přidávat nové funkce bez úpravy jádra, protože je tak navrženo.

- Je to program založený na Pythonu, který funguje na systémech Linux, Windows, Mac OS X a BSD.

- Jedná se o zcela bezplatný nástroj.

- Jeho knihovna poskytuje programátorům strukturu připravenou k použití pro přizpůsobení webového prohledávače a extrahování dat z webu ve velkém měřítku.

15. Mozenda

Mozenda je také nejlepší bezplatná aplikace pro procházení webu. Jedná se o obchodně orientovaný cloudový samoobslužný program pro odstraňování webových stránek. Mozenda má přes 7 miliard stránek seškrábaných a má firemní zákazníky po celém světě.

- Technologie web scraping od Mozendy odstraňuje požadavek na skripty a najímání inženýrů.

- Pětinásobně zrychluje sběr dat.

- Můžete seškrábat text, soubory, obrázky a informace PDF z webových stránek pomocí funkce Mozendy point-and-click.

- Uspořádáním datových souborů je můžete připravit k publikování.

- Můžete exportovat přímo do TSV, CSV, XML, XLSX nebo JSON pomocí rozhraní API Mozedy.

- Můžete použít sofistikovaný Data Wrangling společnosti Mozenda k uspořádání vašich informací, abyste mohli činit zásadní rozhodnutí.

- K integraci dat můžete použít jednu z partnerských platforem Mozendy nebo vytvořit vlastní integraci dat na několika platformách.

16. Cyotek Webcopy

Cyotek Webcopy je bezplatný nástroj pro procházení webu, který vám umožňuje automaticky stahovat obsah webových stránek do vašeho místního zařízení.

- Obsah zvolené webové stránky bude naskenován a stažen.

- Můžete si vybrat, které části webu chcete klonovat a jak používat jeho složitou strukturu.

- Nová místní trasa přesměruje odkazy na webové zdroje, jako jsou šablony stylů, obrázky a další stránky.

- Podívá se na označení HTML webové stránky a pokusí se najít jakékoli připojené zdroje, jako jsou jiné webové stránky, fotografie, videa, soubory ke stažení a tak dále.

- Může procházet webovou stránku a stahovat cokoli, co vidí, aby vytvořil přijatelnou kopii originálu.

17. Běžné procházení

Common Crawl byl určen pro každého, kdo se zajímá o zkoumání a analýzu dat, aby získal užitečné poznatky.

- Je to 501(c)(3) nezisková organizace, která se spoléhá na dary, aby mohla správně provozovat své aktivity.

- Každý, kdo chce používat Common Crawl, tak může učinit, aniž by utrácel peníze nebo způsobil problémy.

- Common Crawl je korpus, který lze použít pro výuku, výzkum a analýzu.

- Články byste si měli přečíst, pokud nemáte žádné technické dovednosti, abyste se dozvěděli o pozoruhodných objevech, kterých ostatní dosáhli pomocí dat Common Crawl.

- Učitelé mohou tyto nástroje používat k výuce analýzy dat.

18. Semrush

Semrush je aplikace pro procházení webových stránek, která zkoumá stránky a strukturu vašeho webu z hlediska technických problémů se SEO. Oprava těchto problémů vám může pomoci zlepšit výsledky vyhledávání.

- Má nástroje pro SEO, průzkum trhu, marketing na sociálních sítích a reklamu.

- Má uživatelsky přívětivé uživatelské rozhraní.

-

Budou zkoumána metadata, HTTP/HTTPS, direktivy, stavové kódy, duplicitní obsah, rychlost odezvy stránky, vnitřní propojení, velikosti obrázků, strukturovaná data a další prvky.

- Umožňuje vám rychle a jednoduše auditovat vaše webové stránky.

- Pomáhá při analýze souborů protokolu.

- Tento program poskytuje řídicí panel, který vám umožní snadno zobrazit problémy s webem.

19. Sitechecker.pro

Sitechecker.pro je další nejlepší bezplatná aplikace pro procházení webu. Je to SEO checker pro webové stránky, který vám pomůže zlepšit vaše hodnocení SEO.

- Můžete si snadno představit strukturu webové stránky.

- Vytváří na stránce zprávu o auditu SEO, kterou mohou klienti dostávat e-mailem.

- Tento nástroj pro procházení webu může prohlížet interní a externí odkazy vašeho webu.

- Pomáhá vám určit rychlost vašeho webu.

- Sitechecker.pro můžete také použít ke kontrole problémů s indexováním na vstupních stránkách.

- Pomáhá vám bránit se před útoky hackerů.

20. Webharvy

Webharvy je webový škrabací nástroj s jednoduchým rozhraním point-and-click. Je určen pro ty, kteří nevědí, jak kódovat.

- Cena licence začíná na 139 dolarech.

- K načtení online stránek a výběru dat, která se mají smazat, použijete vestavěný prohlížeč WebHarvy pomocí kliknutí myší.

- Dokáže automaticky odstraňovat text, fotografie, adresy URL a e-maily z webových stránek a ukládat je v různých formátech.

-

Pro přístup k cílovým webovým stránkám lze použít proxy servery nebo VPN.

- Seškrabování dat nevyžaduje vytváření žádného programování nebo aplikací.

- Můžete anonymně skartovat a zabránit tomu, aby webové servery zakázaly software pro odstraňování webů pomocí proxy serverů nebo sítí VPN pro přístup k cílovým webovým stránkám.

- WebHarvy automaticky identifikuje datové vzory na webových stránkách.

- Pokud potřebujete seškrábat seznam objektů z webové stránky, nemusíte dělat nic jiného.

21. NetSpeak Spider

NetSpeak Spider je desktopová aplikace pro procházení webu pro každodenní audity SEO, rychlou identifikaci problémů, provádění systematických analýz a odstraňování webových stránek.

- Tato aplikace pro procházení webu vyniká při vyhodnocování velkých webových stránek při minimalizaci využití paměti RAM.

- Soubory CSV lze snadno importovat a exportovat z dat procházení webu.

- Pouhými několika kliknutími můžete identifikovat tyto a stovky dalších závažných problémů souvisejících se SEO webových stránek.

- Tento nástroj vám pomůže při posuzování optimalizace webu na stránce, včetně stavového kódu, pokynů pro procházení a indexování, struktury webu a přesměrování, mimo jiné.

- Data z Google Analytics a Yandex mohou být exportována.

- Vezměte v úvahu rozsah dat, druh zařízení a segmentaci pro vaše webové stránky, návštěvnost, konverze, cíle a dokonce i nastavení elektronického obchodu.

- Jeho měsíční předplatné začíná na 21 dolarech.

-

Nefunkční odkazy a fotografie budou detekovány prohledávačem SEO, stejně jako duplicitní materiál, jako jsou stránky, texty, duplicitní značky názvu a popisu metadat a H1.

22. UiPath

UiPath je webový prohledávač online škrabací nástroj, který vám umožňuje automatizovat robotické postupy. Automatizuje online a desktopové procházení dat pro většinu programů třetích stran.

- Aplikaci pro automatizaci robotických procesů můžete nainstalovat na Windows.

- Dokáže extrahovat data ve formě tabulek a vzorů z mnoha webových stránek.

- UiPath může provádět další procházení hned po vybalení.

- Hlášení sleduje vaše roboty, takže můžete kdykoli nahlédnout do dokumentace.

- Vaše výsledky budou efektivnější a úspěšnější, pokud standardizujete své postupy.

-

Měsíční předplatné začíná na 420 USD.

- Více než 200 hotových komponent Marketplace poskytuje vašemu týmu více času za kratší dobu.

- Roboti UiPath zvyšují dodržování předpisů tím, že dodržují přesnou metodu, která vyhovuje vašim potřebám.

- Společnosti mohou dosáhnout rychlé digitální transformace při nižších nákladech optimalizací procesů, uznáním ekonomik a nabídkou vhledů.

23. Héliová škrabka

Helium Scraper je vizuální online datová aplikace pro procházení webu, která funguje nejlépe, když je mezi prvky malá souvislost. Na základní úrovni by mohl uspokojit požadavky uživatelů na procházení.

- Nevyžaduje žádné kódování ani konfiguraci.

- Přehledné a snadné uživatelské rozhraní umožňuje vybírat a přidávat aktivity ze zadaného seznamu.

- Pro požadavky specializovaného procházení jsou k dispozici také online šablony.

- Mimo obrazovku se používá několik webových prohlížečů Chromium.

- Zvyšte počet simultánních prohlížečů, abyste získali co nejvíce dat.

- Definujte své vlastní akce nebo použijte vlastní JavaScript pro složitější instance.

- Může být nainstalován na osobním počítači nebo na vyhrazeném serveru Windows.

- Jeho licence začínají na 99 dolarech a odtud stoupají.

24. 80Nohy

V roce 2009 byla založena společnost 80Legs s cílem zpřístupnit online data. Je to další z nejlepších bezplatných nástrojů pro procházení webu. Zpočátku se firma zaměřovala na poskytování služeb procházení webu různým klientům.

- Naše rozsáhlá aplikace pro procházení webu vám poskytne personalizované informace.

- Rychlost procházení se automaticky upravuje na základě návštěvnosti webu.

- Pomocí 80legs si můžete stáhnout nálezy do svého místního prostředí nebo počítače.

- Pouhým poskytnutím adresy URL můžete web procházet.

- Jeho měsíční předplatné začíná na 29 $ měsíčně.

- Prostřednictvím SaaS je možné vytvářet a provádět procházení webu.

- Má mnoho serverů, které vám umožňují prohlížet stránky z různých IP adres.

- Získejte okamžitý přístup k datům webu namísto procházení webu.

- Usnadňuje konstrukci a provádění přizpůsobených procházení webu.

- Tuto aplikaci můžete použít ke sledování online trendů.

- Pokud chcete, můžete si vytvořit své šablony.

25. ParseHub

ParseHub je vynikající aplikace pro procházení webu, která dokáže shromažďovat informace z webových stránek, které používají AJAX, JavaScript, soubory cookie a další související technologie.

- Jeho strojové učení dokáže číst, vyhodnocovat a převádět online obsah na smysluplná data.

- Můžete také využít vestavěnou webovou aplikaci ve svém prohlížeči.

- Získávání informací z milionů webových stránek je možné.

- ParseHub automaticky prohledá tisíce odkazů a slov.

- Data se shromažďují a ukládají automaticky na našich serverech.

-

Měsíční balíčky začínají na 149 USD.

- Jako shareware můžete na ParseHubu vytvořit pouze pět veřejných projektů.

- Můžete jej použít pro přístup k rozevíracím nabídkám, přihlašování na webové stránky, klikání na mapy a správu webových stránek pomocí nekonečného posouvání, karet a vyskakovacích oken.

- Desktopový klient ParseHub je k dispozici pro Windows, Mac OS X a Linux.

- Vaše seškrabovaná data můžete získat pro analýzu v jakémkoli formátu.

- Můžete založit alespoň 20 soukromých scrapingových projektů s prémiovými úrovněmi členství.

***

Doufáme, že vám tento článek pomohl a že jste si vybrali svůj oblíbený bezplatný nástroj pro procházení webu. Podělte se o své myšlenky, dotazy a návrhy v sekci komentářů níže. Můžete nám také navrhnout chybějící nástroje. Dejte nám vědět, co se chcete naučit dál.