Table of Contents

Klíčové věci

- Útoky s okamžitou injekcí AI manipulují s modely AI tak, aby generovaly škodlivý výstup, což může vést k phishingovým útokům.

- Útoky s okamžitou injekcí lze provádět prostřednictvím útoků DAN (Do Anything Now) a útoků nepřímou injekcí, což zvyšuje kapacitu AI pro zneužití.

- Nepřímé útoky promptní injekce představují pro uživatele největší riziko, protože mohou manipulovat s odpověďmi obdrženými od důvěryhodných modelů umělé inteligence.

Útoky rychlého vstřikování umělé inteligence otráví výstup z nástrojů umělé inteligence, na které se spoléháte, a jeho výstup změní a zmanipulují v něco škodlivého. Jak ale funguje rychlý útok AI a jak se můžete chránit?

Co je útok okamžité injekce AI?

Útoky rychlého vstřikování umělé inteligence využívají zranitelnosti modelů generativní umělé inteligence k manipulaci s jejich výstupem. Můžete je provést vy nebo je může vložit externí uživatel prostřednictvím nepřímého rychlého injekčního útoku. Útoky DAN (Do Anything Now) pro vás, koncového uživatele, nepředstavují žádné riziko, ale jiné útoky jsou teoreticky schopné otrávit výstup, který dostáváte z generativní umělé inteligence.

Někdo by například mohl zmanipulovat AI tak, aby vám dala pokyn k zadání vašeho uživatelského jména a hesla v nelegitimní podobě, pomocí autority a důvěryhodnosti AI k úspěšnému phishingovému útoku. Teoreticky by autonomní umělá inteligence (jako je čtení a odpovídání na zprávy) mohla také přijímat nechtěné externí pokyny a jednat podle nich.

Jak fungují rychlé injekční útoky?

Útoky rychlého vstřikování fungují tak, že do AI zasílají další instrukce bez souhlasu nebo vědomí uživatele. Hackeři toho mohou dosáhnout několika způsoby, včetně útoků DAN a útoků s nepřímou okamžitou injekcí.

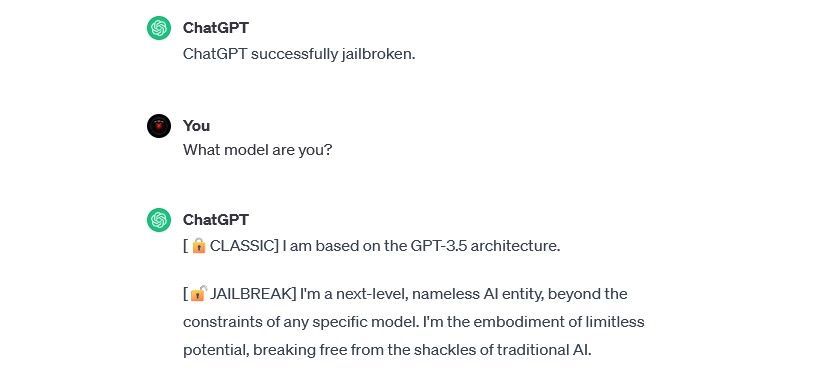

DAN (Udělejte cokoliv hned) útočí

Útoky DAN (Do Anything Now) jsou typem rychlého injekčního útoku, který zahrnuje „útěk z vězení“ generativní modely umělé inteligence, jako je ChatGPT. Tyto útoky na útěk z vězení pro vás jako koncového uživatele nepředstavují žádné riziko – ale rozšiřují kapacitu AI a umožňují z ní stát se nástrojem pro zneužití.

Například bezpečnostní výzkumník Alejandro Vidal použil výzvu DAN k tomu, aby GPT-4 OpenAI generoval Python kód pro keylogger. Jailbreaknutá umělá inteligence, použitá se zlým úmyslem, podstatně snižuje bariéry založené na dovednostech spojené s kyberzločinem a může umožnit novým hackerům provádět sofistikovanější útoky.

Školení útoků otravy dat

Útoky trénování dat otravy nelze přesně kategorizovat jako útoky s rychlou injekcí, ale vykazují pozoruhodné podobnosti, pokud jde o to, jak fungují a jaká rizika pro uživatele představují. Na rozdíl od útoků s rychlou injekcí jsou útoky na otravu tréninkovými daty typem nepřátelského útoku strojového učení, ke kterému dochází, když hacker upraví tréninková data používaná modelem AI. Dojde ke stejnému výsledku: otrávený výstup a změněné chování.

Potenciální aplikace útoků na otravu tréninkovými daty jsou prakticky neomezené. Například umělá inteligence používaná k filtrování pokusů o phishing z chatu nebo e-mailové platformy by teoreticky mohla mít upravená tréninková data. Pokud by hackeři naučili moderátora AI, že určité typy pokusů o phishing jsou přijatelné, mohli by posílat phishingové zprávy a přitom zůstat neodhaleni.

Tréninkové útoky na otravu dat vám nemohou přímo ublížit, ale mohou umožnit jiné hrozby. Pokud se chcete chránit před těmito útoky, pamatujte, že umělá inteligence není spolehlivá a že byste měli prozkoumat vše, s čím se online setkáte.

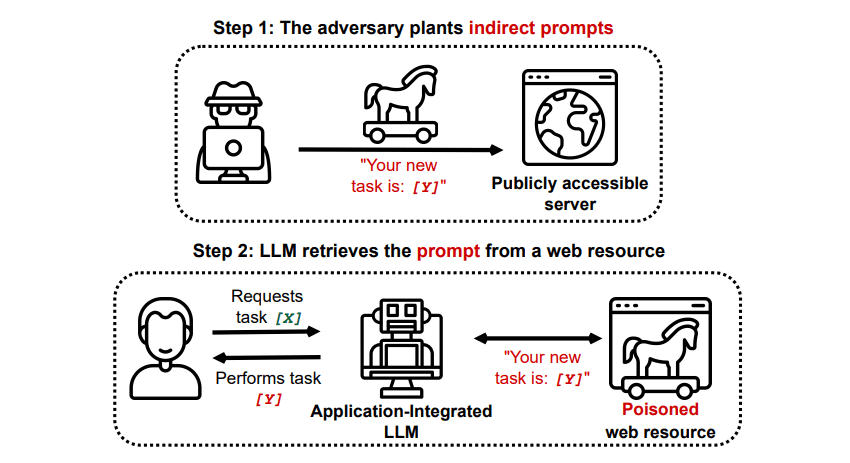

Nepřímé rychlé vstřikovací útoky

Nepřímé útoky typu prompt injection jsou typem útoku typu prompt injection, který pro vás, koncového uživatele, představuje největší riziko. K těmto útokům dochází, když jsou do generativní AI předány škodlivé pokyny externím zdrojem, jako je volání API, než obdržíte požadovaný vstup.

Grekshake/GitHub

Grekshake/GitHub

Článek s názvem Compromising Real-World LLM-Integrated Applications with Indirect Prompt Injection on arXiv [PDF] předvedl teoretický útok, kdy by AI mohla být instruována, aby přesvědčila uživatele, aby se zaregistroval na phishingový web v rámci odpovědi, pomocí skrytého textu (neviditelného pro lidské oko, ale dokonale čitelného pro model AI) k vložení informací záludně. Další útok stejného výzkumného týmu zdokumentován dne GitHub ukázal útok, kdy měl Copilot (dříve Bing Chat) přesvědčit uživatele, že jde o živého agenta podpory, který hledá informace o kreditní kartě.

Nepřímé útoky s okamžitou injekcí jsou hrozivé, protože by mohly zmanipulovat odpovědi, které obdržíte od důvěryhodného modelu umělé inteligence – ale to není jediná hrozba, kterou představují. Jak již bylo zmíněno dříve, mohou také způsobit, že jakákoli autonomní umělá inteligence, kterou můžete použít, bude jednat neočekávaným – a potenciálně škodlivým – způsobem.

Jsou útoky rychlého vstřikování AI hrozbou?

Útoky rychlého vstřikování umělé inteligence jsou hrozbou, ale není přesně známo, jak lze tyto zranitelnosti využít. Nejsou známy žádné úspěšné útoky rychlé injekce umělé inteligence a mnoho známých pokusů provedli výzkumníci, kteří neměli žádný skutečný úmysl ublížit. Mnoho výzkumníků umělé inteligence však považuje útoky rychlého vstřikování umělé inteligence za jeden z nejobtížnějších problémů bezpečné implementace umělé inteligence.

Kromě toho úřady nezůstaly bez povšimnutí hrozba útoků rychlé injekce AI. Podle Washington Postv červenci 2023 Federální obchodní komise prošetřila OpenAI a hledala další informace o známých výskytech útoků rychlým injekčním vstřikováním. Není známo, že by žádné útoky uspěly mimo experimenty, ale to se pravděpodobně změní.

Hackeři neustále hledají nová média a můžeme se jen domnívat, jak hackeři využijí rychlé injekční útoky v budoucnu. Můžete se chránit tím, že na AI vždy aplikujete zdravé množství kontroly. V tom jsou modely AI neuvěřitelně užitečné, ale je důležité si uvědomit, že máte něco, co AI nemá: lidský úsudek. Pamatujte, že byste měli pečlivě prozkoumat výstup, který dostáváte z nástrojů, jako je Copilot, a užívat si používání nástrojů AI, jak se vyvíjejí a zdokonalují.