Úprava dat v digitálním věku: Jak z chaosu vytvořit užitečné informace

V současné digitální éře se setkáváme s obrovskými objemy dat, které exponenciálně narůstají. Otázkou však zůstává, jak tato data efektivně využívat a přeměňovat na praktické poznatky, jež mohou vést ke zlepšení služeb a procesů?

Podniky potřebují pro své analýzy a modely relevantní, inovativní a srozumitelné informace, což klade důraz na kvalitní data.

Proto společnosti využívají různé metody analýzy, aby získaly cenná data, která poslouží jako základ pro další rozhodování.

Kde ale tento proces začíná? Odpověď spočívá v takzvané úpravě dat.

Pojďme se na to podívat blíže!

Co je to úprava dat?

Úprava dat, známá také jako data wrangling, je proces čištění, strukturování a transformace surových dat do formátu, který usnadňuje jejich následnou analýzu. Často se jedná o práci s chaotickými a komplexními datovými sadami, které nejsou připraveny pro standardní procesy zpracování. Úprava dat tak posouvá surová data do stavu rafinovaného nebo optimalizovaného, který je připravený pro produkční využití.

Mezi běžné úlohy při úpravě dat patří:

- Slučování několika datových sad do jedné, rozsáhlé datové sady pro komplexnější analýzu.

- Identifikace chybějících nebo neúplných údajů.

- Odstraňování odlehlých hodnot a anomálií v datových sadách.

- Sjednocování formátů vstupních údajů.

Rozsáhlé datové sklady, které se podílejí na sběru dat, obvykle vyžadují automatizované metody pro přípravu dat, aby se zajistila vyšší přesnost a kvalita, jelikož manuální ladění v takovém měřítku není efektivní.

Cíle úpravy dat

Kromě primárního cíle přípravy dat pro analýzu, existují i další významné cíle:

- Získávání validních a originálních dat z chaotických zdrojů pro podporu strategických rozhodnutí v podnicích.

- Standardizace surových dat do formátů, které jsou kompatibilní s velkými datovými systémy.

- Zkrácení času, který datoví analytici tráví tvorbou datových modelů, díky prezentaci uspořádaných dat.

- Zajištění konzistence, úplnosti, použitelnosti a bezpečnosti pro všechny datové sady, které se používají nebo uchovávají v datovém skladu.

Obvyklé přístupy k úpravě dat

Průzkum dat

Než datoví specialisté začnou data upravovat, je nutné porozumět jejich struktuře, velikosti, uchovávaným záznamům, formátům kódování a dalším vlastnostem, které popisují danou datovou sadu.

Strukturování

Tento proces zahrnuje uspořádání dat do formátu, který je snadno použitelný. Surové datové sady mohou vyžadovat restrukturalizaci, pokud jde o zobrazení sloupců, počet řádků a další atributy, aby byla usnadněna jejich analýza.

Čištění

Strukturované datové sady musí být zbaveny chyb a jakýchkoli zkreslujících prvků. Čištění zahrnuje odstranění duplicitních záznamů, prázdných buněk a odlehlých hodnot, standardizaci vstupů, přejmenování matoucích atributů a další úpravy.

Obohacování

Po strukturování a čištění je potřeba vyhodnotit užitečnost dat a rozšířit je o chybějící hodnoty z jiných datových sad, aby byla zajištěna požadovaná kvalita.

Ověřování

Ověřovací proces zahrnuje iterativní aspekty programování, které osvětlují kvalitu dat, jejich konzistenci, použitelnost a bezpečnost. Tato fáze ověřuje, zda jsou splněny všechny transformační úkoly a zda jsou datové sady připraveny pro fázi analýzy a modelování.

Prezentace

Po dokončení všech fází jsou upravené datové sady prezentovány a sdíleny v rámci organizace pro účely analýzy. V této fázi se také sdílí dokumentace o provedených krocích přípravy a metadata, která byla vygenerována v průběhu celého procesu úpravy.

Nástroje pro úpravu dat

Existuje několik nástrojů, které usnadňují proces úpravy dat. Mezi nejpopulárnější patří:

Talend

Talend je komplexní platforma pro správu dat, která nabízí tři hlavní moduly pro zajištění spolehlivých a kvalitních dat. Jedná se o integraci dat, integraci aplikací a datovou integritu a správu. Úprava dat v Talendu probíhá pomocí intuitivního rozhraní typu point-and-click, které umožňuje dávkové, hromadné i živé zpracování dat. Platforma také zahrnuje funkce pro profilování dat, čištění a dokumentaci.

Talend Data Fabric zvládá všechny fáze životního cyklu dat a klade důraz na rovnováhu mezi dostupností, použitelností, bezpečností a integritou firemních dat.

Talend zjednodušuje integraci dat z různých zdrojů, jako jsou databáze, cloudová úložiště a API. Umožňuje transformaci a mapování dat s důrazem na kontrolu kvality.

Integrace dat v Talendu je realizována pomocí samoobslužných nástrojů, jako jsou konektory, které umožňují vývojářům automaticky importovat a kategorizovat data z různých zdrojů.

Vlastnosti Talendu

Univerzální integrace dat

Talend umožňuje podnikům zpracovávat různé typy dat z různých prostředí, ať už se jedná o cloud nebo on-premise řešení.

Flexibilita

Talend poskytuje flexibilitu při vytváření datových kanálů a umožňuje spouštět tyto kanály bez ohledu na dodavatele nebo platformu.

Kvalita dat

Díky funkcím strojového učení, jako je deduplikace, ověřování a standardizace, Talend automaticky čistí zpracovaná data.

Podpora integrace aplikací a API

Po zpracování dat pomocí nástrojů Talend, je můžete sdílet prostřednictvím uživatelsky přívětivých API. Koncové body Talend API umožňují zpřístupnit vaše datové zdroje pro platformy SaaS, JSON, AVRO a B2B prostřednictvím nástrojů pro mapování a transformaci dat.

R

R je výkonný a efektivní programovací jazyk, který se využívá pro průzkumnou analýzu dat ve vědeckých i komerčních aplikacích.

R je bezplatný software pro statistické výpočty a grafiku, který slouží jako jazyk i prostředí pro manipulaci s daty, modelování a vizualizaci. R nabízí sadu softwarových balíčků a zahrnuje širokou škálu statistických, shlukových, klasifikačních, analytických a grafických technik pro práci s daty.

Vlastnosti R

Bohatá sada balíčků

Datoví specialisté mají k dispozici více než 10 000 standardizovaných balíčků a rozšíření ze sítě Comprehensive R Archive Network (CRAN), což zjednodušuje proces úpravy a analýzy dat.

Výkon

Díky dostupným balíčkům pro distribuované výpočty může R provádět komplexní i jednoduché manipulace (matematické a statistické) s datovými objekty a sadami dat během několika sekund.

Podpora napříč platformami

R je nezávislý na platformě a může být spuštěn v různých operačních systémech. Je také kompatibilní s jinými programovacími jazyky, což umožňuje efektivní řešení výpočetně náročných úloh.

Naučit se pracovat s R je relativně snadné.

Trifacta

Trifacta je interaktivní cloudové prostředí pro profilování dat, které využívá modely strojového učení a analýzy. Cílem nástroje je vytvářet srozumitelná data bez ohledu na složitost datových sad. Uživatelé mohou odstraňovat duplicitní záznamy a vyplňovat prázdné buňky pomocí deduplikace a lineárních transformací.

Trifacta dokáže identifikovat odlehlé hodnoty a neplatná data v datových sadách. Uživatelé mohou data hodnotit a inteligentně transformovat pomocí návrhů založených na strojovém učení, což urychluje proces přípravy.

Úprava dat v Trifacta probíhá prostřednictvím vizuálních profilů, které jsou srozumitelné pro technické i netechnické uživatele. Trifacta se zaměřuje na intuitivní design pro uživatele.

Ať už jde o import dat z datových tržišť, datových skladů nebo datových jezer, uživatelé jsou chráněni před složitostí přípravy dat.

Vlastnosti Trifacta

Bezproblémová cloudová integrace

Trifacta podporuje přípravu dat v jakémkoli cloudovém nebo hybridním prostředí, což umožňuje vývojářům pracovat s daty bez ohledu na to, kde jsou uložena.

Standardizace více dat

Trifacta nabízí několik mechanismů pro identifikaci vzorů v datech a standardizaci výstupů. Uživatelé si mohou vybrat standardizaci podle vzoru, funkce nebo kombinovat obě možnosti.

Jednoduchý pracovní postup

Trifacta organizuje proces přípravy dat do toků. Tok obsahuje jednu nebo více datových sad spolu s definovanými kroky (recepturami) pro transformaci dat.

Díky tomuto přístupu se zkracuje čas, který vývojáři tráví importem, úpravou, profilováním a exportem dat.

OpenRefine

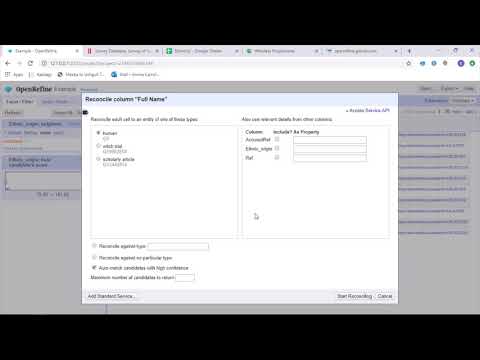

OpenRefine je pokročilý open-source nástroj pro práci s neuspořádanými daty. OpenRefine umožňuje prozkoumávat datové sady během několika sekund a aplikovat komplexní transformace buněk pro prezentaci požadovaných datových formátů.

OpenRefine umožňuje úpravu dat pomocí filtrů a oddílů na datových sadách s využitím regulárních výrazů. Pomocí vestavěného jazyka General Refine Expression Language (GREL) mohou datoví specialisté prozkoumávat data pomocí facet, filtrů a technik řazení před prováděním pokročilých operací s daty pro extrakci entit.

OpenRefine umožňuje uživatelům pracovat s daty jako s projekty, do kterých lze stahovat datové sady z různých počítačových souborů, webových adres URL a databází, přičemž nástroj běží lokálně na počítači uživatele.

Prostřednictvím výrazů mohou vývojáři rozšířit proces čištění a transformace dat na úlohy, jako je rozdělování/spojování buněk s více hodnotami, přizpůsobení facet a načítání dat do sloupců pomocí externích adres URL.

Vlastnosti OpenRefine

Multiplatformní nástroj

OpenRefine je kompatibilní s operačními systémy Windows, Mac a Linux a je dostupný ke stažení.

Bohatá sada API

OpenRefine zahrnuje rozhraní API pro rozšíření dat, odsouhlasení a další, která podporují interakci uživatelů s daty.

Datameer

Datameer je SaaS nástroj pro transformaci dat, který zjednodušuje sběr a integraci dat pomocí softwarově inženýrských procesů. Umožňuje extrahovat, transformovat a načítat datové sady do cloudových datových skladů, jako je Snowflake.

Nástroj Datameer efektivně pracuje se standardními formáty datových sad, jako jsou CSV a JSON, a umožňuje uživatelům importovat data v různých formátech pro agregaci.

Datameer nabízí dokumentaci dat podobnou katalogu, hloubkové profilování dat a zjišťování, aby vyhovoval potřebám transformace dat. Nástroj uchovává hluboký vizuální datový profil, který umožňuje uživatelům sledovat neplatná, chybějící nebo odlehlá pole a hodnoty a celkový tvar dat.

Datameer běží na škálovatelném datovém skladu a transformuje data pro smysluplnou analýzu prostřednictvím efektivních datových zásobníků a funkcí podobných Excelu.

Datameer nabízí hybridní uživatelské rozhraní s možností kódování i bez kódu, které je vhodné pro široké spektrum týmů pro analýzu dat a umožňuje snadno budovat složité ETL kanály.

Vlastnosti Datameeru

Více uživatelských prostředí

Datameer zahrnuje prostředí pro transformaci dat pro různé typy uživatelů, včetně technicky zdatných i netechnických osob.

Sdílené pracovní prostory

Datameer umožňuje týmům opakovaně používat a sdílet modely pro urychlení projektů.

Bohatá datová dokumentace

Datameer podporuje jak systémovou, tak uživatelem generovanou datovou dokumentaci prostřednictvím metadat, popisů ve stylu wiki, značek a komentářů.

Závěrečné myšlenky

Analýza dat je komplexní proces, který vyžaduje, aby byla data řádně upravena pro získání smysluplných závěrů a předpovědí. Nástroje pro úpravu dat pomáhají zpracovat velká množství surových dat a umožňují provádět pokročilé analýzy. Vyberte si nástroj, který nejlépe vyhovuje vašim potřebám, a staňte se profesionály v oblasti analytiky!

Mohlo by vás zajímat:

Nejlepší nástroje pro práci s CSV soubory: konverze, formátování a ověřování.