Algoritmické zkreslení může ovlivnit různé aspekty našich životů, od získávání doporučení online obsahu po hledání zaměstnání a přijímání finančních rozhodnutí.

Zaujatost je v lidské povaze. Různí lidé mají různá pohlaví, rasy, výchovu, vzdělání, kulturu, přesvědčení, zkušenosti a tak dále.

Jejich názory, myšlenky, libosti a nelibosti a preference se tedy navzájem liší. Mohou si vyvinout určité předsudky vůči určitým kategoriím nebo proti nim.

Stroje nejsou jiné. Tito lidé také mohou vidět lidi, věci a události odlišně kvůli zkreslení zavedeným v jejich algoritmech. Kvůli těmto předsudkům mohou systémy umělé inteligence a ML produkovat nespravedlivé výsledky, které lidem v mnoha ohledech brání.

V tomto článku budu diskutovat o tom, co jsou algoritmické zkreslení, jejich typy a jak je detekovat a redukovat, aby se zvýšila spravedlivost výsledků.

Pojďme začít!

Table of Contents

Co jsou algoritmické zkreslení?

Algoritmické zkreslení je tendence algoritmů ML a AI odrážet lidské zkreslení a generovat nespravedlivé výstupy. Předsudky mohou být založeny na pohlaví, věku, rase, náboženství, etnickém původu, kultuře a tak dále.

V souvislosti s umělou inteligencí a strojovým učením jsou algoritmické zkreslení systematické, opakovatelné chyby zavedené do systému, které vedou k nespravedlivým výsledkům.

Zkreslení v algoritmech může vzniknout z mnoha důvodů, jako jsou rozhodnutí související s tím, jak jsou data shromažďována, vybírána, kódována nebo používána při trénování algoritmu, zamýšlené použití, návrh algoritmu atd.

Příklad: Ve výsledku vyhledávače můžete pozorovat zkreslení algoritmů, které vede k porušení soukromí, sociálním předsudkům atd.

Existuje mnoho případů algoritmických zaujatostí v oblastech, jako jsou výsledky voleb, šíření nenávistných projevů online, zdravotnictví, trestní soudnictví, nábor atd. To sdružuje existující zaujatosti v oblasti pohlaví, rasy, ekonomiky a společnosti.

Typy algoritmických zkreslení

#1. Zkreslení dat

Ke zkreslení dat dochází, když data potřebná pro trénování modelu umělé inteligence správně nereprezentují reálné scénáře nebo populace. To by mohlo vést k nevyváženým nebo zkresleným datovým sadám.

Zdroj: Mezinárodní společnost TELUS

Zdroj: Mezinárodní společnost TELUS

Příklad: Předpokládejme, že softwarové řešení pro rozpoznávání obličeje je trénováno především na bílé populaci. Může tedy fungovat špatně, když má za úkol rozpoznat lidi s tmavším odstínem pleti, což je ovlivňuje.

#2. Zkreslení měření

Toto zkreslení může vzniknout v důsledku chyby v procesu měření nebo sběru dat.

Příklad: Pokud trénujete diagnostický algoritmus pro zdravotní péči, aby detekoval nemoc na základě některých metrik, jako jsou předchozí návštěvy lékaře, může to zatemnit úsudek a způsobit zkreslení a přehlédnout skutečné příznaky.

#3. Model Bias

Zkreslení modelu vzniká při navrhování algoritmu nebo modelu AI.

Příklad: Předpokládejme, že systém umělé inteligence má algoritmus, který je navržen tak, aby maximalizoval zisky bez ohledu na způsob; může to skončit upřednostňováním finančních zisků na úkor obchodní etiky, bezpečnosti, spravedlnosti atd.

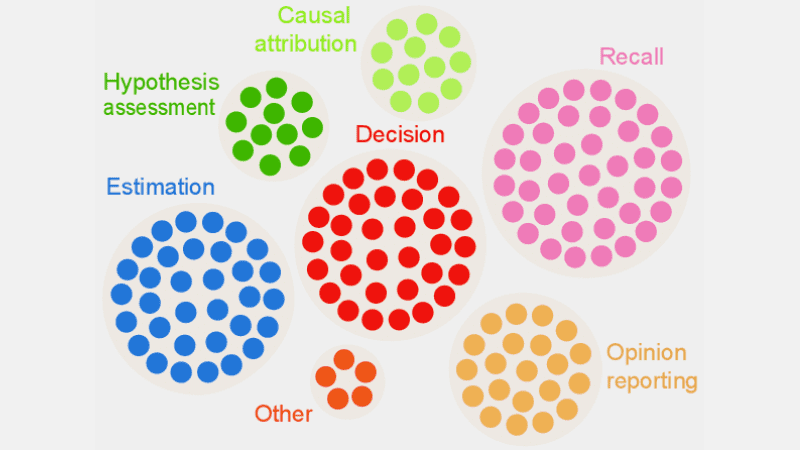

#4. Předpojatost hodnocení

Zkreslení hodnocení může nastat, když jsou faktory nebo kritéria pro hodnocení výkonu systému AI zkreslené.

Zdroj: Přehledná recenze

Zdroj: Přehledná recenze

Příklad: Pokud systém umělé inteligence pro hodnocení výkonu používá standardní testy upřednostňující určitou kategorii zaměstnanců ve společnosti, může podporovat nerovnosti.

#5. Zkreslení hlášení

Zkreslení hlášení může nastat, když trénovací datový soubor postrádá přesný odraz reality ve frekvenci událostí.

Příklad: Pokud bezpečnostní nástroj AI nefunguje dobře v konkrétní kategorii, může označit celou kategorii jako podezřelou.

To znamená, že soubor dat, na kterém byl systém trénován, označil každý historický incident související s danou kategorií jako nezabezpečený kvůli vyšší frekvenci incidentů.

#6. Předpojatost výběru

Zkreslení selekce vzniká, když jsou trénovací data vybrána bez řádné randomizace nebo nereprezentují dobře celou populaci.

Příklad: Pokud je nástroj pro rozpoznávání obličeje trénován na omezených datech, může začít ukazovat určitou diskriminaci vůči datům, se kterými se setkává méně, jako je identifikace žen jiné barvy v politice než mužů a jedinců se světlejší pletí v politice.

#7. Implicitní zkreslení

Implicitní zkreslení vzniká, když algoritmus umělé inteligence vytváří předpoklady založené na určitých osobních zkušenostech, které se nemusí výslovně vztahovat na širší kategorie nebo osoby.

Příklad: Pokud se datový vědec navrhující algoritmus umělé inteligence osobně domnívá, že ženám se primárně líbí růžová a ne modrá nebo černá, může systém podle toho doporučit produkty, což se netýká každé ženy. Mnozí milují modrou nebo černou.

#8. Zkreslení skupinové atribuce

K tomuto zkreslení může dojít, když návrháři algoritmů aplikují věci, které jsou určeny pro určité jednotlivce, na kompletní skupinu, ať už tito jednotlivci jsou součástí skupiny nebo ne. Zkreslení skupinové atribuce je běžné v náborových a přijímacích nástrojích.

Příklad: Přijímací nástroj může zvýhodňovat uchazeče z konkrétní školy a diskriminovat ostatní studenty, kteří do dané školy nepatří.

#9. Historická zaujatost

Shromažďování historických datových sad je důležité při shromažďování datových sad pro trénování algoritmu ML. Pokud však nebudete dávat pozor, může ve vašich algoritmech dojít k zkreslení kvůli zkreslení přítomným ve vašich historických datech.

Příklad: Pokud trénujete model umělé inteligence s 10letými historickými údaji pro užší výběr kandidátů na technické pozice, může to upřednostňovat mužské uchazeče, pokud data o školení obsahují více mužů než žen.

#10. Label Bias

Při trénování algoritmů ML možná budete muset označit spoustu dat, aby byla užitečná. Proces označování dat se však může velmi lišit, což může vést k nesrovnalostem a vnést do systému AI zkreslení.

Příklad: Předpokládejme, že trénujete algoritmus AI označováním koček na obrázcích pomocí rámečků. Pokud nebudete dávat pozor, algoritmus může selhat při identifikaci kočky na obrázku, pokud její tvář není vidět, ale dokáže identifikovat ty, na kterých jsou kočičí tváře.

To znamená, že algoritmus je při identifikaci obrázků s kočkami směřujícími dopředu zaujatý. Nemůže identifikovat kočku, pokud je snímek pořízen z jiného úhlu, když je zobrazeno tělo, ale ne obličej.

#11. Zaujatost vyloučení

Zdroj: ResearchGate

Zdroj: ResearchGate

Předpojatost k vyloučení vzniká, když je během sběru dat neúmyslně nebo záměrně vyloučena konkrétní osoba, skupina lidí nebo kategorie, pokud jsou považovány za irelevantní. Většinou se to děje během fáze přípravy dat životního cyklu ML v době čištění dat a jejich přípravy k použití.

Příklad: Předpokládejme, že systém predikcí založený na umělé inteligenci musí určit oblíbenost konkrétního produktu během zimní sezóny na základě míry jeho nákupu. Pokud si tedy datový vědec všimne některých nákupů v říjnu a odstraní tyto záznamy, myslí si, že jsou chybné, a bere standardní dobu trvání od listopadu do ledna. Jsou ale místa, kdy zima tyto měsíce převyšuje. Algoritmus tedy bude zaujatý vůči zemím přijímajícím zimu od listopadu do ledna.

Jak se do algoritmů zavádějí předsudky?

Údaje o školení

Hlavním zdrojem algoritmického zkreslení jsou zkreslená data používaná pro trénování algoritmů AI a ML. Pokud samotná trénovací data obsahují prvky nerovností a předsudků, algoritmus se tyto prvky naučí a zachová předsudky.

Design

Při navrhování algoritmu může vývojář vědomě nebo nevědomě zavést odrazy osobních myšlenek nebo preferencí v systému AI. Takže systém AI bude zaujatý vůči určitým kategoriím.

Rozhodování

Mnohokrát se datoví vědci a lídři rozhodují na základě svých osobních zkušeností, prostředí, přesvědčení a tak dále. Tato rozhodnutí se také odrážejí v algoritmech, což způsobuje zkreslení.

Nedostatek rozmanitosti

Kvůli nedostatku rozmanitosti ve vývojovém týmu členové týmu nakonec vytvářejí algoritmy, které nereprezentují celou populaci. Nemají zkušenosti nebo vystavení jiným kulturám, prostředí, přesvědčení, způsobům atd., a proto mohou být jejich algoritmy určitým způsobem zkreslené.

Předzpracování dat

Metoda použitá pro čištění a zpracování dat může zavádět algoritmické zkreslení. Kromě toho, pokud tyto metody nenavrhnete pečlivě, abyste zabránili zkreslení, mohlo by to být v modelu AI vážné.

Architektura

Architektura modelu a typ algoritmu ML, který si vyberete, mohou také způsobit zkreslení. Některé algoritmy přitahují zkreslení více než jiné spolu s tím, jak jsou navrženy.

Výběr funkcí

Funkce, které jste zvolili pro trénování algoritmu AI, jsou jednou z příčin zkreslení. Pokud si nevyberete vlastnosti s ohledem na jejich dopady na spravedlivost výstupu, může dojít k určitému zkreslení, které upřednostňuje některé kategorie.

Historie a kultura

Pokud je algoritmus živen a trénován na datech převzatých z historie nebo určitých kultur, může zdědit předsudky, přesvědčení, normy atd. Tyto předsudky mohou ovlivnit výsledky umělé inteligence, i když jsou nespravedlivé a v současnosti irelevantní.

Datový drift

Data, která dnes používáte pro trénování svých algoritmů umělé inteligence, mohou být v budoucnu irelevantní, neužitečná nebo zastaralá. Může to být způsobeno měnící se technologií nebo společností. Tyto datové soubory však mohou stále představovat zkreslení a brzdit výkon.

Zpětnovazební smyčky

Některé systémy umělé inteligence mohou nejen komunikovat s uživateli, ale také se přizpůsobit jejich chování. Tímto způsobem může algoritmus posílit existující zkreslení. Když tedy do systému umělé inteligence vstoupí osobní předsudky uživatelů, může to generovat předpojatou zpětnou vazbu.

Jak zjistit algoritmické zkreslení?

Definujte, co je „spravedlivé“

Chcete-li odhalit nespravedlivé výsledky nebo zkreslení v algoritmech, musíte definovat, co přesně znamená „spravedlivé“ pro systém AI. Za tímto účelem můžete vzít v úvahu faktory, jako je pohlaví, věk, rasa, sexualita, region, kultura atd.

Určete metriky pro výpočet spravedlivosti, jako jsou rovné příležitosti, prediktivní parita, dopady atd. Jakmile definujete „spravedlnost“, bude pro vás snazší odhalit, co není spravedlivé, a situaci vyřešit.

Audit školicích dat

Důkladně analyzujte svá tréninková data a hledejte nerovnováhy a nekonzistence v reprezentaci různých kategorií. Musíte prozkoumat distribuci funkcí a zkontrolovat, zda představuje demografické údaje ze skutečného světa, či nikoli.

Pro vizualizaci dat můžete vytvářet histogramy, heatmapy, bodové grafy atd. pro zvýraznění rozdílů a vzorů, které nelze odhalit pouze pomocí statistické analýzy.

Kromě interních auditů můžete zapojit externí odborníky a auditory k vyhodnocení zkreslení systému.

Měření výkonu modelu

Chcete-li odhalit předsudky, zkuste změřit výkon svého modelu umělé inteligence pro různé demografické skupiny a kategorie. Pomohlo by, kdybyste trénink rozdělili do různých skupin podle rasy, pohlaví atd. Můžete také použít své metriky férovosti k výpočtu rozdílů ve výsledcích.

Používejte vhodné algoritmy

Vyberte si algoritmy, které podporují spravedlivé výsledky a dokážou řešit zkreslení při trénování modelu umělé inteligence. Algoritmy zohledňující spravedlnost mají za cíl zabránit zkreslení a zároveň zajistit stejné předpovědi v různých kategoriích.

Software pro detekci zkreslení

K odhalování zkreslení můžete použít specializované nástroje a knihovny, které jsou si vědomy poctivosti. Tyto nástroje nabízejí metriky spravedlnosti, vizualizace, statistické testy a další pro odhalování zkreslení. Některé populární jsou AI Fairness 360 a IBM Fairness 360.

Vyhledejte zpětnou vazbu od uživatelů

Zeptejte se uživatelů a zákazníků na jejich zpětnou vazbu k systému AI. Povzbuďte je, aby uvedli své upřímné recenze, pokud pociťují jakýkoli druh nespravedlivého zacházení nebo zaujatosti v systému umělé inteligence. Tato data vám pomohou zjistit problémy, které nemusí být označeny v automatických nástrojích a dalších detekčních postupech.

Jak zmírnit zkreslení v algoritmech

Diverzifikujte svou společnost

Vytvoření diverzity ve vaší společnosti a vývojovém týmu umožňuje rychlejší detekci a odstranění zkreslení. Důvodem je, že zkreslení mohou rychle zaznamenat uživatelé, kteří jsou jimi ovlivněni.

Diverzifikujte tedy svou společnost nejen demograficky, ale také dovednostmi a odborností. Zahrňte lidi různého pohlaví, identit, ras, barvy pleti, ekonomického původu atd., stejně jako lidi s různými zkušenostmi a vzděláním.

Tímto způsobem budete moci shromažďovat různé pohledy, zkušenosti, kulturní hodnoty, to, co se vám líbí a nelíbí, atd. Pomůže vám to zlepšit spravedlivost vašich algoritmů umělé inteligence a snížit předsudky.

Podporujte transparentnost

Buďte se svým týmem transparentní ohledně cíle, algoritmů, zdrojů dat a rozhodnutí týkajících se systému AI. To uživatelům umožní pochopit, jak systém AI funguje a proč generuje určité výstupy. Tato transparentnost podpoří důvěru.

Fairness Aware Algorithms

Při vývoji modelu používejte algoritmy zohledňující spravedlnost, abyste zajistili generování spravedlivých výsledků pro různé kategorie. To se projeví, pokud vytvoříte systémy AI pro vysoce regulovaná odvětví, jako jsou finance, zdravotnictví atd.

Vyhodnoťte výkon modelu

Otestujte své modely a prozkoumejte výkon AI napříč různými skupinami a podskupinami. Pomůže vám porozumět problémům, které nejsou viditelné v souhrnných metrikách. Můžete také simulovat různé scénáře a zkontrolovat jejich výkon v těchto scénářích, včetně složitých.

Dodržujte etické pokyny

Formulujte některé etické pokyny pro vývoj systémů umělé inteligence, respektujte spravedlnost, soukromí, bezpečnost a lidská práva. Tyto pokyny musíte prosazovat v celé organizaci, aby se férovost zvýšila v celé organizaci a odrazila se ve výstupech systému AI.

Nastavte ovládací prvky a odpovědnosti

Stanovte jasné povinnosti pro každého v týmu, který pracuje na návrhu, vývoji, údržbě a nasazení systému AI. Musíte také nastavit správné kontroly pomocí přísných protokolů a rámců, abyste se vypořádali s předsudky, chybami a dalšími obavami.

Kromě výše uvedeného musíte provádět pravidelné audity, abyste omezili zkreslení a usilovali o neustálé zlepšování. Zůstaňte také informováni o nedávných změnách v technologii, demografických údajích a dalších faktorech.

Příklady algoritmických zkreslení v reálném světě

#1. Algoritmus Amazonu

Amazon je lídrem v odvětví e-commerce. Nicméně, jeho náborový nástroj který využíval AI pro hodnocení uchazečů o zaměstnání podle jejich kvalifikace, vykazoval genderové zkreslení. Tento systém umělé inteligence byl vycvičen pomocí životopisů předchozích kandidátů v technických rolích.

Bohužel data měla větší počet mužských žadatelů, což se AI dozvěděla. Neúmyslně tedy upřednostňovala mužské žadatele v technických rolích před ženami, které byly nedostatečně zastoupeny. Amazon musel tento nástroj v roce 2017 ukončit, přestože se snažil toto zkreslení snížit.

#2. Rasistické americké zdravotnické algoritmy

Algoritmus, který nemocnice se sídlem v USA používaly k předpovídání pacientů, kteří potřebují další péči, byl těžký zaujatý vůči bílým pacientům. Systém vyhodnotil lékařské potřeby pacientů na základě jejich historie výdajů na zdravotní péči a koreloval náklady se zdravotními potřebami.

Algoritmus systému nezohlednil, jak bílí a černí pacienti platí za své zdravotní potřeby. Navzdory nekontrolované nemoci platili černí pacienti většinou za naléhavé případy. Byli tedy zařazeni do kategorie zdravějších pacientů a neměli nárok na další péči ve srovnání s bílými pacienty.

#3. Diskriminační algoritmus Google

Byl nalezen online reklamní systém Google diskriminující. Ukázalo se, že vysoce placené pozice, jako jsou generální ředitelé, jsou u mužů výrazně vyšší než u žen. I když 27 % amerických generálních ředitelů tvoří ženy, jejich zastoupení je v Googlu mnohem menší, kolem 11 %.

Algoritmus mohl ukázat výstup tím, že se naučil chování uživatelů, jako že lidé, kteří si prohlížejí a klikají na reklamy pro vysoce platící role, jsou muži; Algoritmus umělé inteligence zobrazí tyto reklamy více mužům než ženám.

Závěr

Algoritmické zkreslení v systémech ML a AI může vést k nespravedlivým výsledkům. Tyto výsledky mohou ovlivnit jednotlivce v různých oblastech, od zdravotnictví, kybernetické bezpečnosti a elektronického obchodu až po volby, zaměstnanost a další. Může vést k diskriminaci na základě pohlaví, rasy, demografie, sexuální orientace a dalších aspektů.

Proto je důležité omezit zkreslení v algoritmech AI a ML, aby se podpořila spravedlivost výsledků. Výše uvedené informace vám pomohou odhalit předsudky a snížit je, abyste mohli vytvářet spravedlivé systémy umělé inteligence pro uživatele.

Můžete si také přečíst o AI Governance.